前言¶

概述

本文用于指导开发人员基于现有模型、使用SVP ACL(Smart Vision Processing Advanced Computing Language)提供的C语言API库开发图像分析工具应用,用于实现目标识别、图像分类等功能。

产品版本

与本文档相对应的产品版本如下。

产品名称 |

产品版本 |

|---|---|

SS928 |

V100 |

SS927 |

V100 |

读者对象

本文档适用于基于SVP ACL接口进行应用开发的人员,通过本文档您可以达成:

了解SVP ACL的功能架构、基本概念以及接口的典型调用流程。

使用SVP ACL接口进行应用开发的基本流程和实现方法。

能够基于本文档中的样例,扩展进行其它应用的开发。

掌握以下经验和技能可以更好地理解本文档:

具备C++/C语言程序开发能力。

对机器学习、_图像分析方法_有一定的了解。

修改记录

文档版本 |

发布日期 |

修改说明 |

|---|---|---|

00B01 |

2025-09-15 |

第1次临时版本发布。 |

使用约束¶

不支持使用fork函数创建多个进程,且在进程中调用SVP ACL接口的场景,否则进程运行时会报错或者卡死。

对于创建类接口(例如:svp_acl_rt_create_context 、svp_acl_rt_create_stream、svp_acl_create_data_buffer等),用户调用该类接口创建对应的资源后,资源使用完成后,建议及时调用对应的销毁类接口(例如:svp_acl_rt_destroy_context、svp_acl_rt_destroy_stream、svp_acl_destroy_data_buffer等),否则,程序可能会异常。

对于销毁类接口(例如:svp_acl_rt_destroy_context、svp_acl_rt_destroy_stream、svp_acl_rt_free、svp_acl_destroy_data_buffer等),用户调用该类接口后,不能继续使用已释放或销毁的资源,建议用户调用销毁类接口后,将相关资源设置为无效值(例如,置为NULL)。

一个Device上默认最多只能支持64个用户进程。

新手指引¶

文档结构总览¶

本文档分为以下几章:

前言:介绍文档概述和读者对象。

使用约束:介绍SVP ACL的总体使用约束。

新手指引:介绍文档结构、接口命名规则。

简介:介绍SVP(Smart Vision Platform)ACL(Advanced Computing Language)的基础知识,包括功能、基本概念、各概念之间的关系、如何查看日志等。

接口调用流程介绍:介绍各场景下的SVP ACL接口调用流程。

开发流程:介绍使用SVP ACL提供的接口开发应用的基本步骤。

准备环境:介绍准备开发环境和板端环境时需要参考的文档。

开发首个应用:以开发图片分类应用(不包含抠图、缩放、解码等数据预处理的开发)为例,按照开发流程,结合示例代码,介绍各步骤的基本原理。

开发典型功能点的介绍:SVP ACL各功能点的详细介绍。

SVP ACL API参考:介绍API的功能、原型、参数等。

SVP ACL样例使用指导:介绍如何使用SVP ACL提供的样例。

表达约定¶

接口命名规则¶

接口命名同时满足如下规则:

规则1:svp_acl+接口类别缩写+操作动词+对象

规则2:操作动词和对象均采用小写

接口类别¶

接口类别 |

缩写 |

描述 |

|---|---|---|

runtime |

rt |

表示运行管理类的接口。 |

model |

mdl |

表示模型推理类的接口。 |

注:

缩写原则上不超过4个字母

在接口命名中,如果类别与操作对象重叠时,操作动词后的对象将省略。

如:svp_acl_mdl_load_from_mem,表示model类接口,这个接口表示含义是load model from mem,因此在接口命名中Load后面 mdl将被省略。

简介¶

本文用于指导开发人员基于现有模型、使用SVP ACL(Smart Vision Processing Advanced Computing Language)提供的C语言API库开发图像分析工具应用,用于实现目标识别、图像分类等功能。

什么是SVP ACL¶

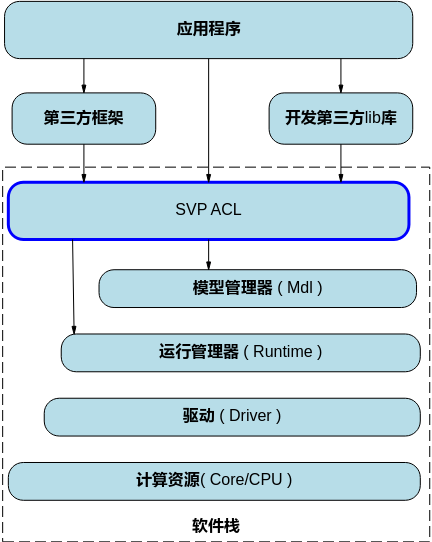

SVP ACL(Smart Vision Processing Advanced Computing Language)提供Device管理、Context管理、Stream管理、内存管理、模型加载与执行等C语言API库供用户开发图像分析工具应用,用于实现目标识别、图像分类等功能。用户可以通过第三方框架调用SVP ACL接口,以便使用SoC的计算能力;用户还可以使用SVP ACL封装实现第三方lib库,以便提供SoC的运行管理、资源管理能力。

在运行应用时,SVP ACL调用mdl管理器提供的接口实现模型的加载与执行、调用运行管理器的接口实现Device管理/Context管理/Stream管理/内存管理等。

计算资源层是SoC的硬件算力基础,主要完成图像分析工具的矩阵相关计算、完成控制算子/标量/向量等通用计算和执行控制功能、完成图像和视频数据的预处理,为图像分析工具计算提供了执行上的保障。

图 1 逻辑架构图

基本概念¶

表 1 概念介绍

概念 |

描述 |

|---|---|

同步/异步 |

本文中提及的同步、异步是站在调用者和执行者的角度,在当前场景下,若在板端环境调用接口后不等待Device执行完成再返回,则表示板端环境的调度是异步的;若在板端环境调用接口后需等待Device执行完成再返回,则表示板端环境的调度是同步的。 |

进程/线程 |

本文中提及的进程、线程,若无特别注明,则表示板端环境上的进程、线程。 |

Device |

Device表示板端环境上的图像分析引擎。 |

Context |

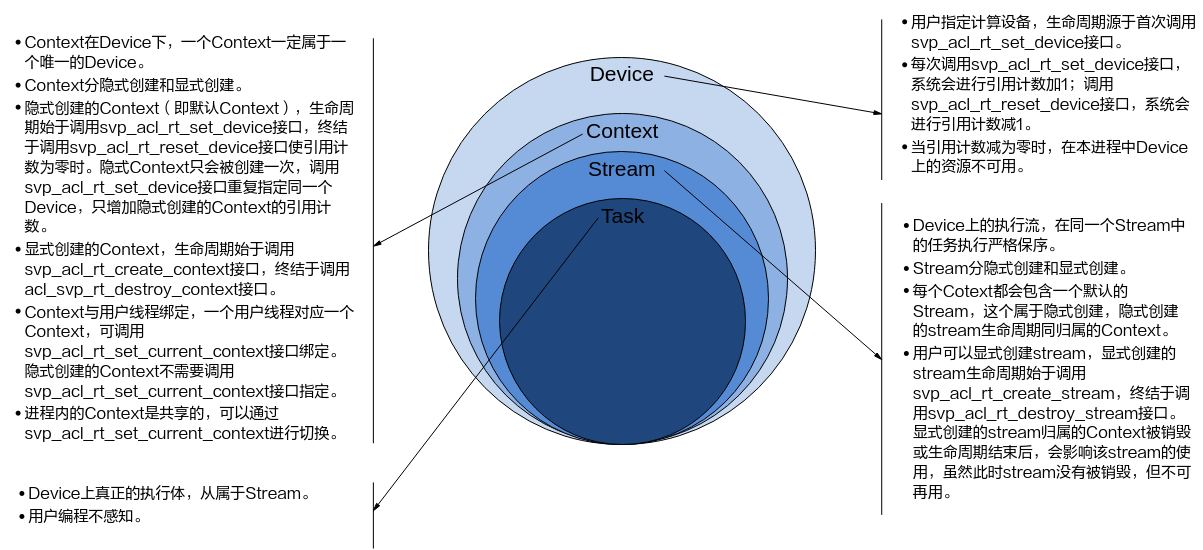

Context作为一个容器,管理了所有对象(包括Stream、设备内存等)的生命周期。不同Context的Stream之间、不同的Context之间是完全隔离的,无法建立同步等待关系。 Context分为两种:

|

Stream |

Stream用于维护一些异步操作的执行顺序,确保按照应用程序中的代码调用顺序在Device上执行。 Stream分两种:

|

动态Batch/动态分辨率 |

在某些场景下,模型每次输入的Batch数或分辨率是不固定的,如检测出目标后再执行目标识别网络,由于目标个数不固定导致目标识别网络输入BatchSize不固定。

|

动态维度(ND格式) |

为了支持Transformer等网络在输入格式的维度不确定的场景,需要支持ND格式下任意维度的动态设置。 ND表示支持任意格式,当前N≠4。 |

通道 |

在RGB色彩模式下,图像通道就是指单独的红色R、绿色G、蓝色B部分。也就是说,一幅完整的图像,是由红色绿色蓝色三个通道组成的,它们共同作用产生了完整的图像。 |

进程、线程、Device、Context、Stream之间的关系¶

各基本概念的介绍请参见基本概念。

Device、Context、Stream之间的关系¶

线程、Context、Stream之间的关系¶

一个用户线程一定会绑定一个Context,所有Device的资源使用或调度,都必须基于Context。

一个线程中当前会有一个唯一的Context在用,Context中已经关联了本线程要使用的Device。

可以通过svp_acl_rt_set_current_context进行Device的快速切换。示例代码如下,仅供参考,不可以直接拷贝编译运行:

… svp_acl_rt_create_context(&ctx1, 0); svp_acl_mdl_execute(mdl1, input1, output1); svp_acl_rt_create_context(&ctx2,1); /*在当前线程中,创建ctx2后,当前线程对应的Context切换为ctx2,对应在Device 1进行后续的计算任务,本例中将在Device 1上进行mdl2的执行调用 */ svp_acl_mdl_execute(mdl2, input2, output2); svp_acl_rt_set_current_context(ctx1); /*在当前线程中,通过Context切换,使后续模型计算任务在对应的Device 0上进行*/ svp_acl_mdl_execute(mdl3, input3, output3); …

一个线程中可以创建多个Stream,不同的Stream上计算任务是可以并行执行;多线程场景下,也可以每个线程创建一个Stream,线程之间的Stream在Device上相互独立,每个Stream内部的任务是按照Stream下发的顺序执行。

多线程的调度依赖于运行应用的操作系统调度,Device侧多Stream调度,由Device上调度组件进行调度。

一个进程内多个线程间的Context迁移¶

一个进程中可以创建多个Context,但一个线程同一时刻只能使用一个Context。

线程中创建的多个Context,线程缺省使用最后一次创建的Context。

进程内创建的多个Context,可以通过svp_acl_rt_set_current_context设置当前需要使用的Context。

默认Context和默认Stream的使用场景¶

Device上执行操作下发前,必须有Context和Stream,这个Context、Stream可以显式创建,也可以隐式创建。隐式创建的Context、Stream就是默认Context、默认Stream。

默认Stream作为接口入参时,直接传NULL。

默认Context不允许用户执行svp_acl_rt_get_current_context或svp_acl_rt_set_current_context操作,也不允许执行svp_acl_rt_destroy_context操作。

默认Context、默认Stream一般适用于简单应用,用户仅仅需要一个Device的计算场景下。多线程应用程序建议全部使用显式创建的Context和Stream。

示例代码如下,仅供参考,不可以直接拷贝编译运行:

…

svp_acl_init(...);

svp_acl_rt_set_device(0);

/*已经创建了一个default ctx,在default ctx中创建了一个default stream,并且在当前线程可用*/

…

svp_acl_mdl_execute_async(mdl1,input1,output1,NULL); //最后一个NULL表示在default stream上执行模型mdl1

svp_acl_mdl_execute_async(mdl2,input2,output2,NULL); //最后一个NULL表示在default stream上执行模型mdl2

svp_acl_rt_synchronize_stream(NULL);

/*等待计算任务全部完成(mdl1、mdl2执行结束),用户根据需要获取计算任务的输出结果*/

…

svp_acl_rt_reset_device(0); //释放计算设备0,对应的default ctx及default stream生命周期也终止

多线程、多stream的性能说明¶

线程调度依赖运行的操作系统,Stream上下发了任务后,Stream的调度由Device的调度单元调度,但如果一个进程内的多Stream上的任务在Device存在资源争抢的时候,性能可能会比单Stream低。

当前芯片有不同的执行部件,如模式识别Core、模式识别CPU等,对应使用不同执行部件的任务,建议多Stream的创建按照算子执行引擎划分。

单线程多Stream与多线程多Stream(进程属于多线程,每个线程中一个Stream)性能上哪个更优,具体取决于应用本身的逻辑实现,一般来说前者性能略好,原因是相对后者,应用层少了线程调度开销。

SVP ACL内存申请使用说明¶

用户内存管理有两种管理方式:

独立内存管理,根据需要单独申请所需的内存,内存不做拆分或者二次分配。

内存池管理内存,用户一次性申请一块较大内存,并在使用时从这块较大内存中二次分配所需内存。

在内存二次分配时,使用如下接口从内存池申请对应内存,由于接口对申请的内存地址、大小有约束,在内存池管理时,需要关注,否则容易出现内存越界。

接口

用途

输入内存/输出内存

svp_acl_rt_malloc

申请Device上的内存,同步接口。

- 使用svp_acl_rt_malloc接口申请的内存,需要通过svp_acl_rt_free接口释放内存。

- 频繁调用svp_acl_rt_malloc接口申请内存、调用svp_acl_rt_free接口释放内存,会损耗性能,建议用户提前做内存预先分配或二次管理,避免频繁申请/释放内存。

svp_acl_rt_malloc_host

申请Host或Device上的内存,Device上的内存按普通页申请。同步接口。

- 使用svp_acl_rt_malloc_host接口申请的内存,需要通过svp_acl_rt_free_host接口释放内存。

- 如果没有Host端,调用该接口会获取Device侧内存,也可调用svp_acl_rt_free释放。

- 频繁调用svp_acl_rt_malloc_host接口申请内存、调用svp_acl_rt_free_host接口释放内存,会损耗性能,建议用户提前做内存预先分配或二次管理,避免频繁申请/释放内存。

如何获取Sample¶

当前SVP ACL提供的样例如表1所示。

表 1 Sample列表

Sample |

基本功能 |

样例介绍、编译及运行 |

|---|---|---|

resnet50_imagenet_classification |

基于Caffe ResNet-50网络实现图片分类(同步推理) |

基于Caffe ResNet-50网络实现图片分类(同步推理) |

resnet50_async_imagenet_classification |

基于Caffe ResNet-50网络实现图片分类(异步推理) |

基于Caffe ResNet-50网络实现图片分类(异步推理) |

切至发布包Sample目录,解压samples.tar.gz

tar -zxvf samples.tar.gz

如何查看日志¶

在控制台上可以使用cat命令查看信息,cat /dev/logmpp查看错误日志。

如何查看Proc信息¶

概述¶

调试信息采用了Linux下的proc文件系统,可实时反映当前系统的运行状态,所记录的信息可供问题定位及分析时使用。

【文件目录】

/proc/umap

【信息查看方法】

在控制台上可以使用cat命令查看信息,cat /proc/umap/svp_nnn;也可以使用其他常用的文件操作命令,例如 cp /proc/umap/svp_nnn ./,将文件拷贝到当前目录。

在应用程序中可以将上述文件当作普通只读文件进行读操作,例如fopen、fread等。

说明: 参数在描述时有以下2种情况需要注意:

取值为{0, 1}的参数,如未列出具体取值和含义的对应关系,则参数为1时表示肯定,为0时表示否定。

取值为{aaa, bbb, ccc}的参数,未列出具体取值和含义的对应关系,但可直接根据取值aaa、bbb或ccc判断参数含义。

Proc信息说明¶

【调试信息】

# cat /proc/umap/svp_nnn

[SVP_NNN] Version: [xxxxVx.x.x.x B0xx Release], Build Time[mm dd yyyy, hh:mm:ss]

---------------------------svp_nnn module param--------------------------

nnn_save_power max_task_node_num

0 512

---------------------------svp_nnn resource info------------------------

free_model_num

63

device_id free_stream_num free_report_num free_task_node_num

0 127 128 511

---------------------------svp_nnn busy stream info----------------------

device_id stream_id report_id block_type send_task_num

0 0 -1 1 0

timeout_err_cnt hw_err_cnt aacpu_err_cnt

0 0 0

model_task_handle model_task_handle_wrap model_task_finish

1 0 0

model_task_finish_wrap

0

callback_task_handle callback_task_handle_wrap callback_task_finish

0 0 0

callback_task_finish_wrap

0

----------------------svp_nnn sync model task info-----------------

device_id task_send_num task_send_num_wrap task_finish_num task_finish_num_wrap

0 1 0 1 0

---------------------------svp_nnn irq info------------------------------

device_id irq_cnt_last_sec max_irq_cnt_per_sec total_irq_cnt

0 17 17 181

cur_irq_time max_irq_time irq_time_last_sec max_irq_time_per_sec

8 24 180 180

total_irq_time

2445

---------------------------svp_nnn runtime info--------------------------

device_id hw_status last_stream_id last_task_node_id net_seg_idx

0 0 0 0 446

net_seg_num

610

timeout_err_cnt hw_err_cnt aacpu_err_cnt

0 0 0

last_hw_task_time hw_utilization total_running_time

13 0% 897

【调试信息分析】

记录当前SVP图像分析引擎模块参数信息,资源信息,被调用stream信息,中断信息和运行时状态信息。

【参数说明】

参数 |

描述 |

|

|---|---|---|

svp_nnn module param SVP图像分析引擎 模块参数 |

nnn_save_power |

低功耗标志。 0:关闭低功耗; 1:打开低功耗。 |

max_task_node_num |

最大任务节点个数,范围[1, 4096],默认为512个,用户可通过模块参数svp_nnn_max_task_node_num配置。配置方式是在加载svp_nnn的ko时,使用"svp_nnn_max_task_node_num=512"参数并修改"512"的值,将其配置成需要设置的数值。 |

|

svp_nnn resource info SVP图像分析引擎资源信息 |

free_model_num |

剩余可加载的模型个数。 |

device_id |

设备ID。 |

|

free_stream_num |

剩余可申请的Stream个数。 |

|

free_report_num |

剩余可申请的report个数。 |

|

free_task_node_num |

剩余可申请的task节点个数。 |

|

svp_nnn busy stream info SVP图像分析引擎运行stream的信息 |

device_id |

设备ID。 |

stream_id |

Stream ID。 |

|

report_id |

Stream注册的report ID。如果为-1,则Stream没有注册report。 |

|

block_type |

阻塞类型。 0:没有被阻塞; 1:被逻辑任务阻塞; 2:被模式识别CPU任务阻塞; 3:被Callback任务阻塞。 |

|

send_task_num |

下发到Stream上的任务个数。 |

|

timeout_err_cnt |

Stream上发生超时错误的个数。 |

|

hw_err_cnt |

Stream上发生逻辑错误的个数。 |

|

aacpu_err_cnt |

Stream上发生模式识别CPU任务执行错误的个数。 |

|

model_task_handle |

模型推理任务handle。 |

|

model_task_handle_wrap |

模型推理任务handle发生回写次数。 |

|

model_task_finish |

已完成模型推理任务个数。 |

|

model_task_finish_wrap |

已完成模型推理任务数发生回写的次数。 |

|

callback_task_handle |

Callback任务handle。 |

|

callback_task_handle_wrap |

Callback任务handle发生回写次数。 |

|

callback_task_finish |

已完成Callback任务个数。 |

|

callback_task_finish_wrap |

已完成Callback任务数发生回写的次数。 |

|

svp_nnn irq info SVP图像分析引擎中断信息 |

device_id |

设备ID。 |

irq_cnt_last_sec |

最近1秒内中断执行次数。 |

|

max_irq_cnt_per_sec |

历史上的1秒内最大的中断执行次数。 |

|

total_irq_cnt |

产生中断的总次数。 |

|

cur_irq_time |

最近一次执行中断的执行耗时。 单位:us。 |

|

max_irq_time |

执行一次中断的最大耗时。 单位:us。 |

|

irq_time_last_sec |

最近一秒执行中断的执行耗时。 单位:us。 |

|

max_irq_time_per_sec |

历史上一秒内执行中断的最大耗时。 单位:us。 |

|

total_irq_time |

中断处理总时间。 单位:us。 |

|

svp_nnn sync model task info SVP图像分析引擎同步模型任务信息 |

device_id |

设备ID。 |

task_send_num |

下发任务个数。 |

|

task_send_num_wrap |

下发任务数发生回绕的次数。 |

|

task_finish_num |

完成任务个数。 |

|

task_finish_num_wrap |

完成任务数发生回绕的次数。 |

|

svp_nnn runtime info SVP图像分析引擎设备运行信息 |

device_id |

设备ID。 |

hw_status |

硬件所处状态。 0:空闲。 1:工作。 |

|

last_stream_id |

最近一次下发任务到图像分析引擎的Stream id。 |

|

last_task_node_id |

最近一次在图像分析引擎上执行的任务节点id。 |

|

net_seg_idx |

最近一次图像分析引擎任务被执行的网络段索引。 |

|

net_seg_num |

最近一次图像分析引擎任务含有的网络段数。 |

|

timeout_err_cnt |

设备上发生超时错误的个数。 |

|

hw_err_cnt |

设备上发生逻辑错误的个数。 |

|

aacpu_err_cnt |

设备上发生模式识别CPU任务执行错误的个数 |

|

last_hw_task_time |

最近一次图像分析引擎执行任务的耗时。 |

|

hw_utilization |

最近1s内硬件执行时间所占的比例。 |

|

total_running_time |

设备运行总时间。 单位:s |

|

备注:loadSS928V100脚本位置在版本包目录/mpp/out/ko/路径下。其中loadSS928V100脚本默认加载PQP的ko,PQP与svp__nnn_是互斥的,不能同时加载,需要手动修改loadSS928V100脚本加载svp__nnn_的ko。

接口调用流程介绍¶

主要接口调用流程¶

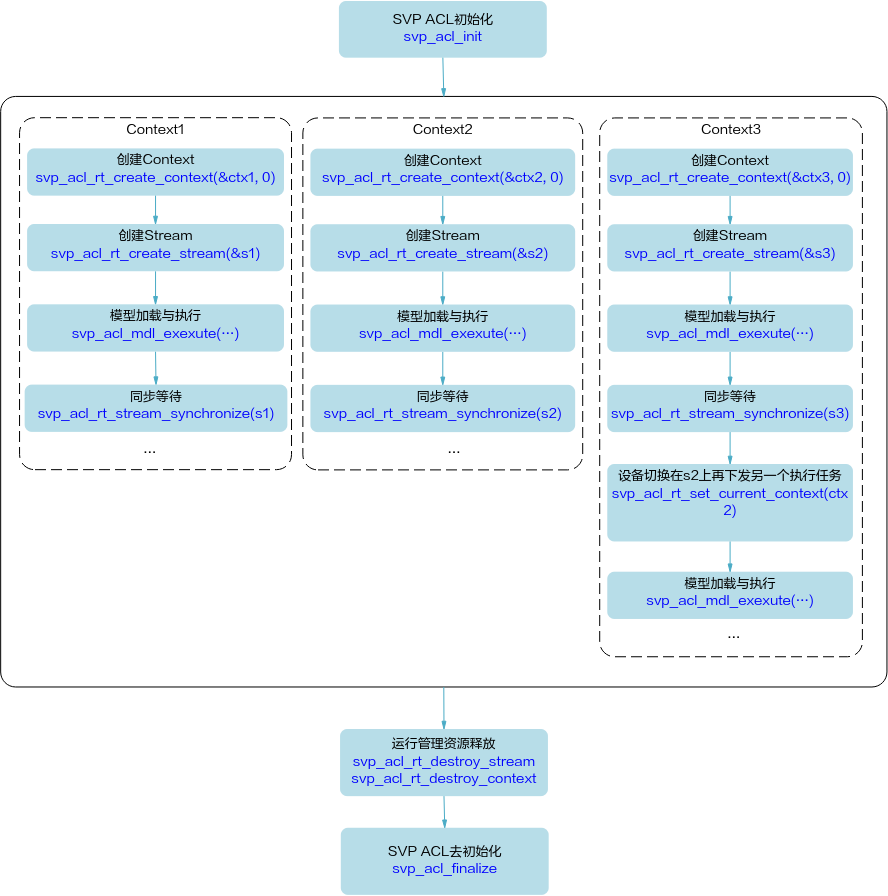

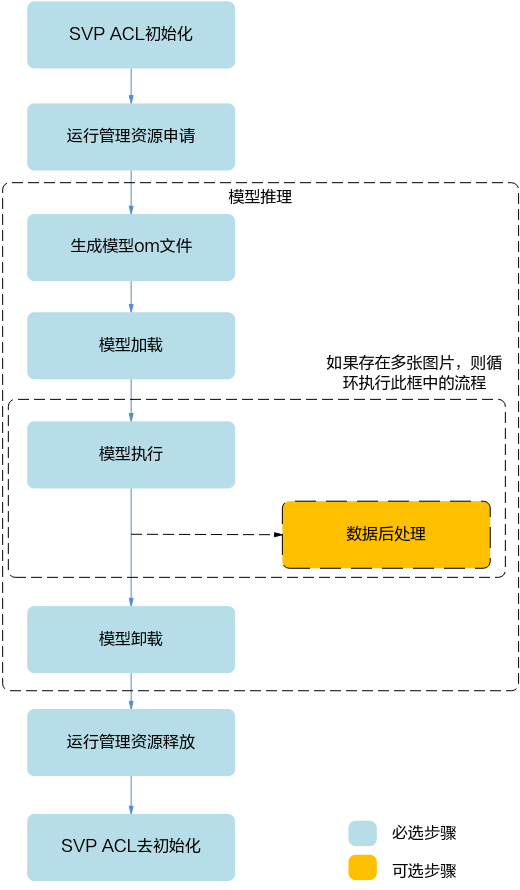

图 1 接口调用流程图

上图根据应用开发中的典型功能抽象出主要的接口调用流程,例如,如果需要实现模型推理的功能,则需要先加载模型,模型推理结束后,则需要卸载模型;如果模型推理后,需要从推理结果中查找最大置信度的类别标识对图片分类,则需要数据后处理。

SVP ACL初始化:调用svp_acl_init接口实现初始化SVP ACL。

运行管理资源申请:依次申请运行管理资源:Device、Context、Stream。具体流程,请参见“运行管理资源申请”。

模型推理。

生成模型om文件:需使用ATC工具将第三方网络(例如,Caffe ResNet-50网络)转换为适配SoC的离线模型(*.om文件),请参见《ATC工具使用指南》。

模型加载:模型推理前,需要先将对应的模型加载到系统中。具体流程,请参见“模型加载”。

模型执行:使用模型实现图片分类、目标识别等功能,目前SVP ACL提供同步推理接口和异步推理接口,支持动态Batch、动态分辨率等场景。具体流程,请参见“模型执行”。

(可选)数据后处理:处理模型推理的结果,此处根据用户的实际需求来处理推理结果,例如用户可以将获取到的推理结果写入文件、从推理结果中找到每张图片最大置信度的类别标识等。

模型卸载:调用svp_acl_mdl_unload接口卸载模型。

运行管理资源释放:所有数据处理都结束后,需要依次释放运行管理资源:Stream、Context、Device。具体流程,请参见“运行管理资源释放”。

SVP ACL去初始化:调用svp_acl_finalize接口实现SVP ACL去初始化。

说明:

在应用开发过程中,各环节都涉及内存的申请与释放、数据传输(通过内存复制实现)、数据类型的创建与销毁,因此未在图中一一标识,关于内存申请与释放、内存复制的接口请参见“内存管理”,数据类型的创建与销毁的接口请参见“数据类型及其操作接口”。

说明:

在应用开发过程中,各环节都涉及内存的申请与释放、数据传输(通过内存复制实现)、数据类型的创建与销毁,因此未在图中一一标识,关于内存申请与释放、内存复制的接口请参见“内存管理”,数据类型的创建与销毁的接口请参见“数据类型及其操作接口”。

运行管理资源申请¶

您需要依次申请运行管理资源,包括:Device、Context、Stream。其中创建Context、Stream的方式分为隐式创建和显式创建。

隐式创建Context和Stream:适合简单、无复杂交互逻辑的应用,但缺点在于,在多线程编程中,每个线程都使用默认Context或默认Stream,默认Stream中任务的执行顺序取决于操作系统线程调度的顺序。

显式创建Context和Stream:推荐显式,适合大型、复杂交互逻辑的应用,且便于提高程序的可读性、可维护性。

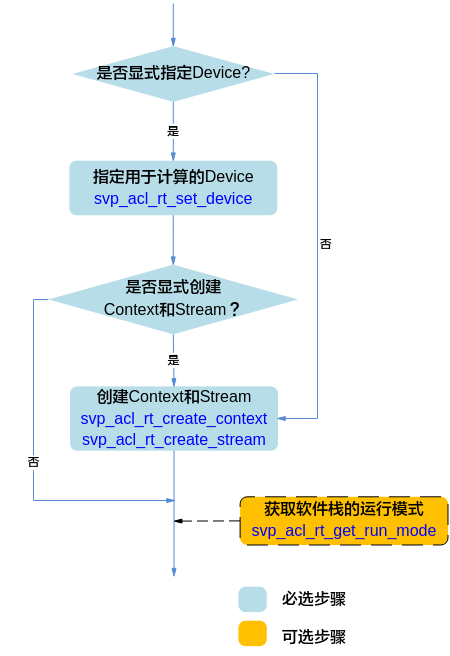

图 1 运行管理资源申请流程

申请运行管理资源时,需按顺序依次申请:Device、Context、Stream。

调用svp_acl_rt_set_device接口显式指定用于运算的Device。

调用svp_acl_rt_create_context接口显式创建Context,调用svp_acl_rt_create_stream接口显式创建Stream。

不显式创建Context和Stream,系统会使用默认Context、默认Stream,该默认Context、默认Stream是在调用svp_acl_rt_set_device接口时隐式创建的。

默认Stream作为接口入参时,直接传NULL。

不显式指定用于运算的Device。

调用svp_acl_rt_create_context接口显式创建Context,调用svp_acl_rt_create_stream接口显式创建Stream。系统在显式创建Context时,系统内部会调用svp_acl_rt_set_device接口指定运行的Device,Device ID通过svp_acl_rt_create_context接口传入。

(可选)调用svp_acl_rt_get_run_mode接口获取软件栈的运行模式,根据运行模式来判断后续的内存申请接口调用逻辑,如果查询结果为SVP_ACL_HOST,则数据传输时涉及申请Host上的内存;如果查询结果为SVP_ACL_DEVICE,则数据传输时不涉及申请Host上的内存,仅需申请Device上的内存。

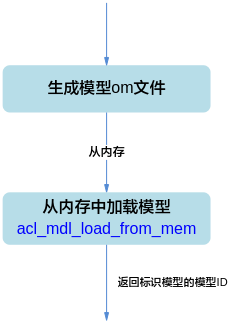

模型加载¶

图 1 模型加载流程

在模型加载前,需使用ATC工具将第三方网络(例如,Caffe ResNet-50网络)转换为适配SoC的离线模型(*.om文件),请参见《ATC工具使用指南》。

支持以下方式加载模型,模型加载成功后,返回标识模型的模型ID:

svp_acl_mdl_load_from_mem:从内存加载离线模型数据,由系统内部管理内存。

模型执行¶

基本的模型执行流程¶

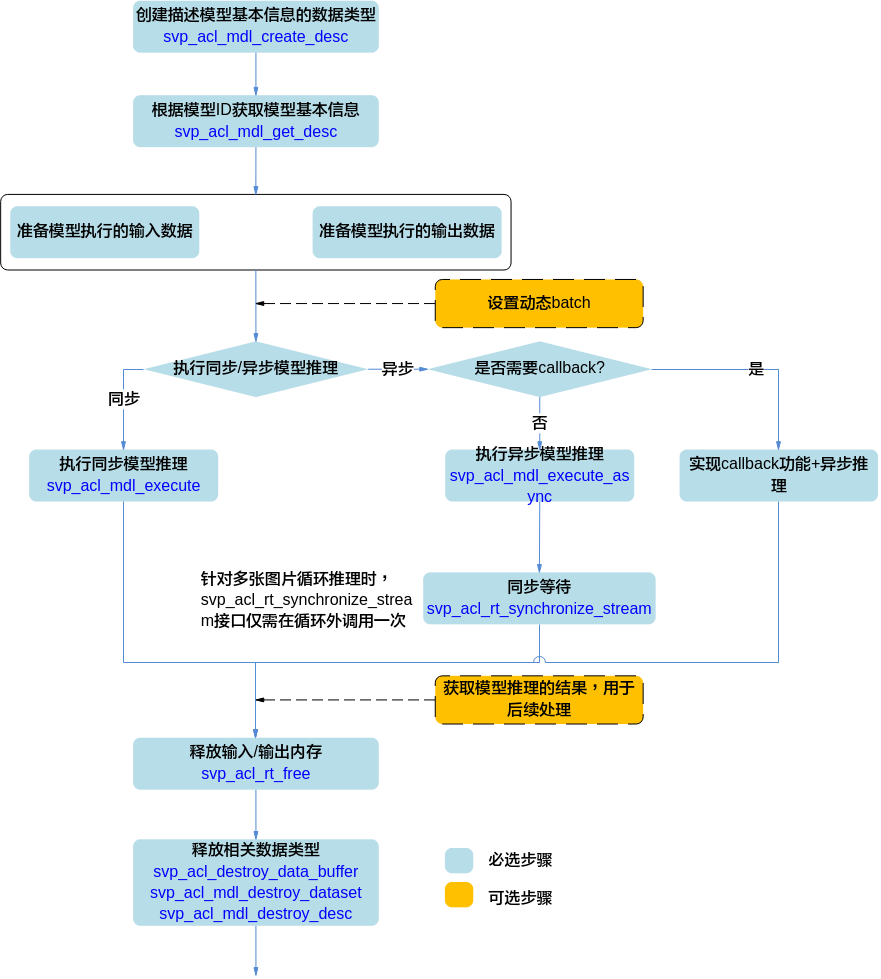

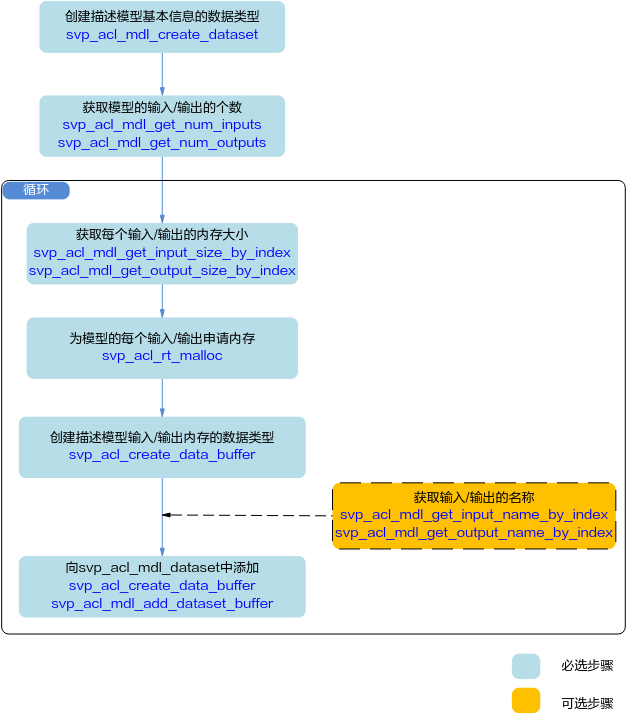

图 1 基本的模型推理流程

模型执行的关键流程说明如下:

调用svp_acl_mdl_create_desc接口创建描述模型基本信息的数据类型。

调用svp_acl_mdl_get_desc接口根据“模型加载”中返回的模型ID获取模型基本信息。

准备模型执行的输入、输出数据,具体流程,请参见“准备模型执行的输入/输出数据”。

设置动态Batch的具体流程,请参见“设置动态Batch和Total_t”。

执行模型推理。

当前系统支持模型的同步推理和异步推理:

同步推理时调用svp_acl_mdl_execute接口

异步推理时调用svp_acl_mdl_execute_async接口

对于异步接口,还需调用svp_acl_rt_synchronize_stream接口阻塞Host运行,直到指定Stream中的所有任务都完成。

如果同时需要实现Callback功能,请参见“Callback场景”。

获取模型推理的结果,用于后续处理。

对于同步推理,直接获取模型推理的输出数据即可。

对于异步推理,在实现Callback功能时,在回调函数内获取模型推理的结果,供后续使用。

释放内存。

调用svp_acl_rt_free接口释放Device上的内存。

释放相关数据类型的数据。

在模型推理结束后,需及时调用svp_acl_destroy_data_buffer接口和svp_acl_mdl_destroy_dataset接口释放描述模型输入的数据,且先调用svp_acl_destroy_data_buffer接口,再调用svp_acl_mdl_destroy_dataset接口。如果存在多个输入、输出,需调用多次svp_acl_destroy_data_buffer接口。

设置动态Batch和Total_t¶

须知:

Recurrent网络只支持设置动态batch为1,支持设置Total_t(要处理的总帧数);非Recurrent网络只支持设置动态batch,不支持设置Total_t。

图片输入时最大batch数为256。非图片输入时,最大batch数为5000。

准备模型推理的动态Batch输入的数据,详细流程请参见“准备模型执行的输入/输出数据”。

设置动态batch之前需要先调用svp_acl_mdl_get_input_index_by_name接口根据输入名称获取模型中标识动态Batch输入的index,动态Batch输入的名称固定为SVP_ACL_DYNAMIC_TENSOR_NAME,然后再调用svp_acl_mdl_set_dynamic_batch_size接口根据index设置动态batch。

申请动态Batch输入对应的内存前,需要先调用svp_acl_mdl_get_num_inputs获取输入个数,然后调用svp_acl_mdl_get_input_size_by_index接口根据index获取单batch所需内存大小,乘以用户要设置的动态batch值得到需要的内存大小(task_buf和work_buf不需要乘以动态batch值,详细请参见“准备模型执行的输入/输出数据”)。

说明:

SVP_ACL_DYNAMIC_TENSOR_NAME是一个宏,宏的定义如下:

说明:

SVP_ACL_DYNAMIC_TENSOR_NAME是一个宏,宏的定义如下:#define SVP_ACL_DYNAMIC_TENSOR_NAME "svp_acl_mbatch_shape_data"在成功加载模型之后,执行模型之前,设置动态Batch数或者设置Total_t。

设置动态Batch数

调用svp_acl_mdl_set_dynamic_batch_size接口设置动态Batch数。

设置Total_t

调用svp_acl_mdl_set_total_t接口设置Recurrent网络推理的帧数。

设置动态分辨率¶

准备模型推理的动态分辨率输入的数据,详细流程请参见“准备模型执行的输入/输出数据”。

设置动态分辨率之前需要先调用svp_acl_mdl_get_input_index_by_name接口根据输入名称获取模型中标识动态分辨率输入的index,动态分辨率输入的名称固定为SVP_ACL_DYNAMIC_TENSOR_NAME。

设置动态分辨率之前,调用svp_acl_mdl_get_input_size_by_index或者svp_acl_mdl_get_output_size_by_index接口根据index获取的是默认分辨率(最大分辨率)的size。

设置动态分辨率之前,调用svp_acl_mdl_get_input_default_stride或者svp_acl_mdl_get_output_default_stride接口根据index获取的是默认分辨率(最大分辨率)的stride。

设置动态分辨率之前,调用svp_acl_mdl_get_input_dims或者svp_acl_mdl_get_output_dims接口根据index获取的是默认分辨率(最大分辨率)的dims。

设置动态分辨率之后,以上接口获取的size/stride/dims是当前设置的分辨率的size/stride/dims;workbuf/taskbuf获取的(最大分辨率)size/stride/dims。

说明:

SVP_ACL_DYNAMIC_TENSOR_NAME是一个宏,宏的定义如下:

说明:

SVP_ACL_DYNAMIC_TENSOR_NAME是一个宏,宏的定义如下:#define SVP_ACL_DYNAMIC_TENSOR_NAME "svp_acl_mbatch_shape_data"当前动态分辨率的设置是跟随模型的,所以不支持多个线程同时对加载的一个模型进行同时设置不同的分辨率;当前支持的场景是设置一个分辨率,跑推理,当前推理完成;切换分辨率,继续推理。

在成功加载模型之后,执行模型之前,设置动态分辨率大小。

调用svp_acl_mdl_get_dynamic_hw接口获取支持的动态分辨率个数和大小。

调用svp_acl_mdl_set_dynamic_hw_size接口根据index设置动态分辨率大小。

准备模型执行的输入/输出数据¶

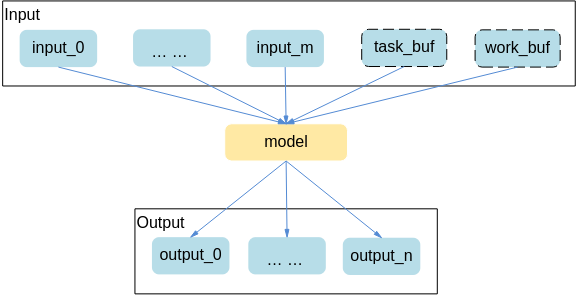

图 1 模型输入/输出数据

准备输入内存时需要额外输入两块内存,分别为task_buf,work_buf,对应的输入索引为M-2和M-1(M是通过svp_acl_mdl_get_num_inputs接口获取的输入个数)。在申请动态batch内存时,这两块内存不需要乘以batch值。

说明:

task_buf用于填充模型推理的任务信息,当前模型推理完之前不能被修改或被其他模型推理任务使用,task_buf的大小不为0。

work_buf用于任务执行时存储中间结果,一个stream上如果会执行不同的模型,开辟一个最大的work_buf即可,这些模型在该stream上推理时可以共用,不同stream间不能共用,work_buf大小不为0。

图 2 模型执行的输入/输出数据准备流程

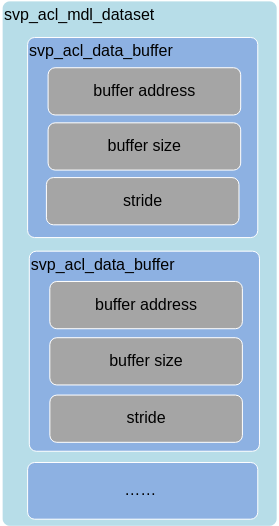

使用svp_acl_mdl_desc类型的数据描述模型基本信息(例如输入/输出的个数、名称、数据类型、Format、维度信息等),使用svp_acl_mdl_dataset类型的数据描述模型的输入/输出数据,模型可能存在多个输入、多个输出,每个输入/输出的内存地址、内存大小用svp_acl_data_buffer类型的数据来描述。

图 3 svp_acl_mdl_dataset类型与svp_acl_data_buffer类型的关系

模型存在多个输入、输出时,用户在向svp_acl_mdl_dataset中添加svp_acl_create_data_buffer时,为避免顺序出错,可以先获取输入、输出的名称,根据输入、输出名称所对应的index的顺序添加。

说明: 在创建svp_acl_data_buffer类型的数据时,内存大小可以通过调用svp_acl_mdl_get_input_size_by_index接口根据index获取。

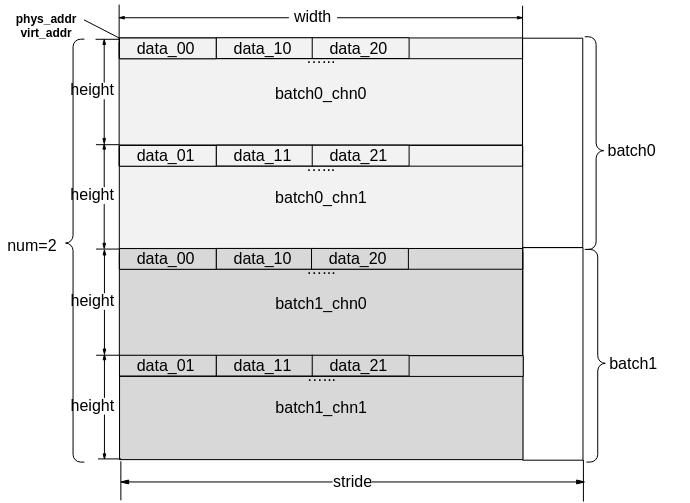

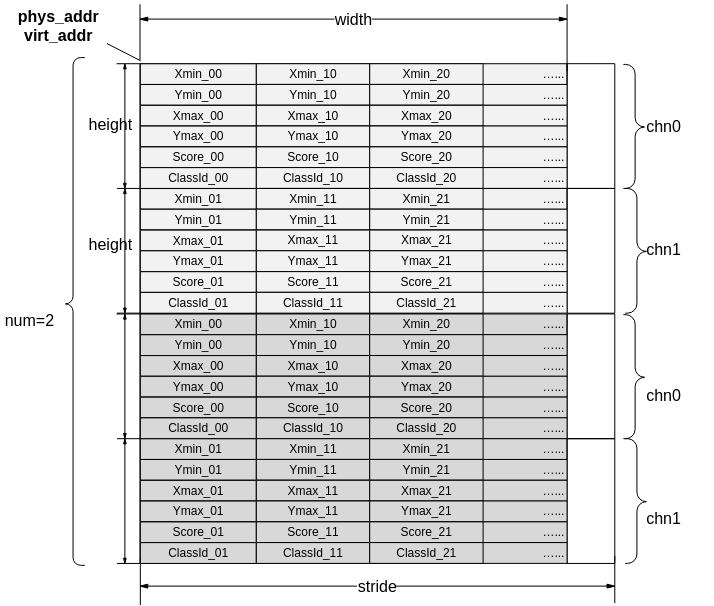

图 4 模型输入/输出数据排布(通道为2,batch为2示意图)

SVP_ACL输入输出数据stride都是按照最后一维对齐,除YVU420SP与YUV420SP输入格式外,数据排布都如图4所示。

如果是RGB_PACKAGE格式,data_xx数据类型为U24,通道数为1。

如果是XRGB_PACKAGE格式,data_xx数据类型为U32,通道数为1。

如果是XBGR_PACKAGE格式,data_xx数据类型为U32,通道数为1。

如果是RGBX_PACKAGE格式,data_xx数据类型为U32,通道数为1。

如果是BGRX_PACKAGE格式,data_xx数据类型为U32,通道数为1。

如果是BGR_PACKAGE格式,data_xx数据类型为U24,通道数为1。

如果是BGR_PLANAR格式,data_xx数据类型为U8,通道数为3。

如果是RGB_PLANAR格式,data_xx数据类型为U8,通道数为3。

如果是XRGB_PLANAR格式,data_xx数据类型为U8,通道数为3。

如果是XBGR_PLANAR格式,data_xx数据类型为U8,通道数为3。

如果是RGBX_PLANAR格式,data_xx数据类型为U8,通道数为3。

如果是BGRX_PLANAR格式,data_xx数据类型为U8,通道数为3。

如果是RAW_RGGB格式,data_xx数据类型为U8/U12/U14/U16,通道数为1。

如果是RAW_GRBG格式,data_xx数据类型为U8/U12/U14/U16,通道数为1。

如果是RAW_GBRG格式,data_xx数据类型为U8/U12/U14/U16,通道数为1。

如果是RAW_BGGR格式,data_xx数据类型为U8/U12/U14/U16,通道数为1。

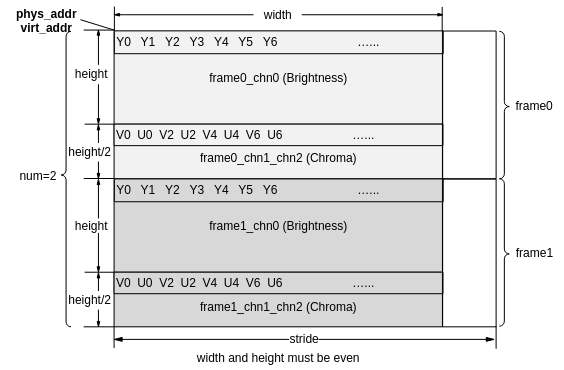

图 5 YVU420SP/YUV420SP数据排布(通道为2,frame为2示意图)

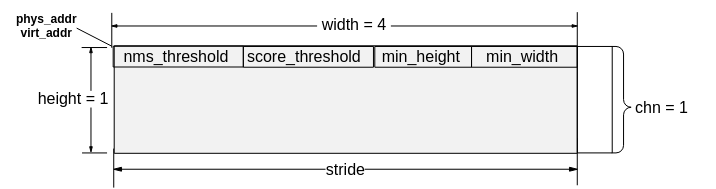

SVP_ACL支持检测网阈值通过data层传入,阈值输入固定长度为4,分别是nms_threshold,score_threshold,min_height,min_width,同时将检测网络输出的检测框结果数据排布进行了统一,检测网阈值和检测框结果排布格式如图7所示。

图 6 检测网阈值输入数据排布

图 7 检测框结果数据排布(通道为2,chn为2示意图)

同步等待¶

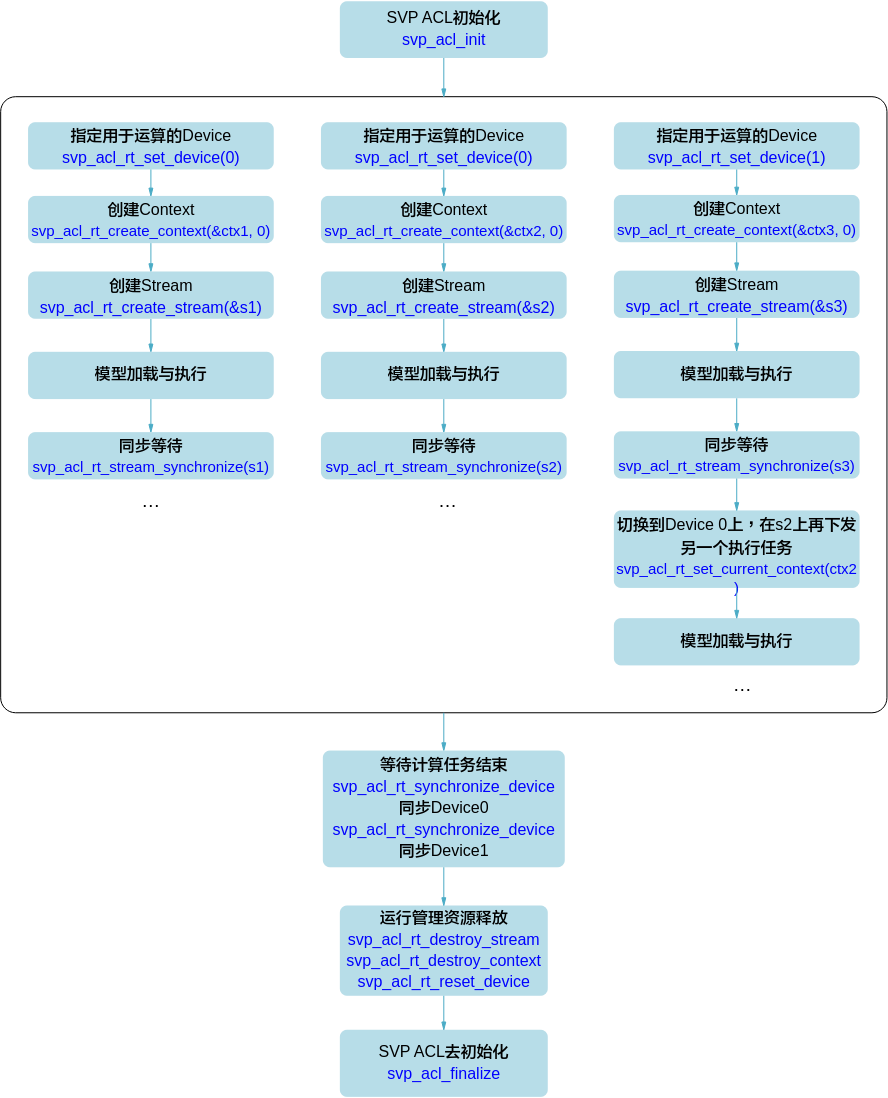

多Device场景¶

图 1 同步等待流程多Device场景

在多Device时,利用Context切换(调用svp_acl_rt_set_current_context接口)来切换Device,比使用svp_acl_rt_set_device接口效率高。

调用svp_acl_rt_synchronize_device接口等待Device上的计算任务结束。

模型加载的流程请参见“模型加载”,模型执行的流程请参见“模型执行”。

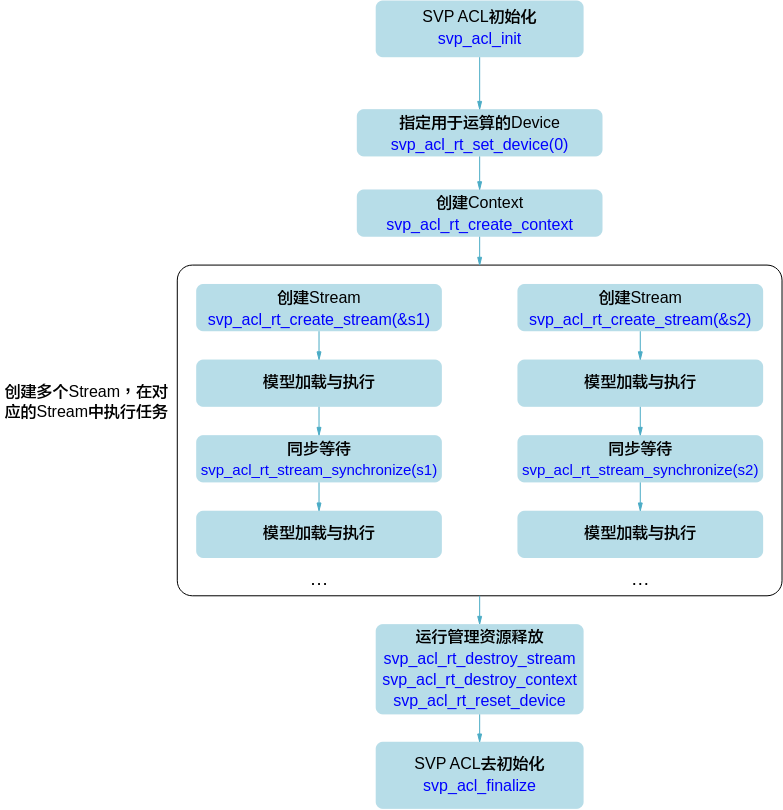

多Stream场景¶

图 1 同步等待流程多Stream场景

模型加载的流程请参见“模型加载”,模型执行的流程请参见“模型执行”。

Callback场景¶

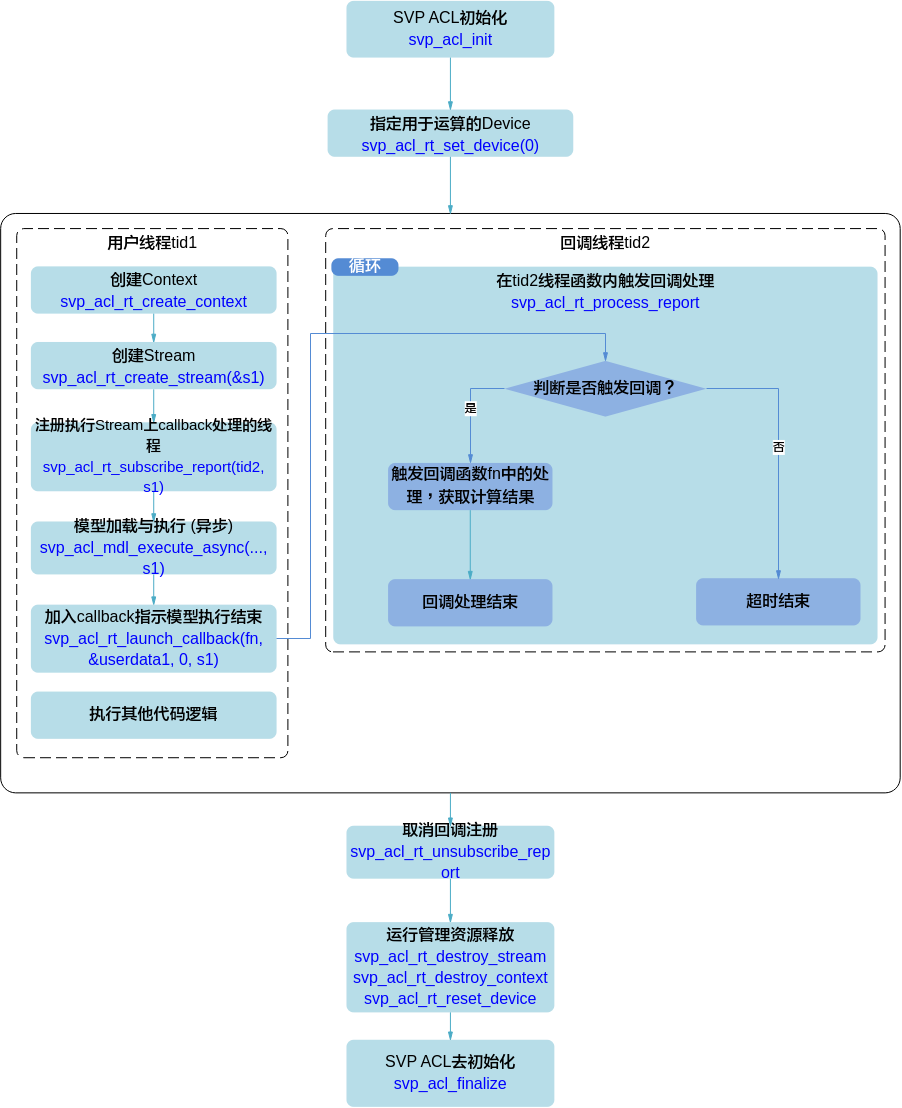

图 1 同步等待流程Callback场景模型推理

Callback流程中关键流程说明如下:

回调函数fn需由用户提前创建,用于获取并处理模型推理或算子执行的结果。

线程tid2需由用户提前创建,并自定义线程函数,在线程函数内调用svp_acl_rt_process_report接口,等待指定时间后,触发回调函数。

调用svp_acl_rt_subscribe_report接口:指定处理Stream上回调函数的线程,线程与tid2保持一致。

调用svp_acl_rt_launch_callback接口:在Stream的任务队列中增加一个需要在板端环境上执行的回调函数,回调函数与fn保持一致。

调用svp_acl_rt_unsubscribe_report接口:取消线程注册(Stream上的回调函数不再由指定线程处理)。

如果是异步推理Callback场景,为确保Stream中所有任务都完成、模型推理的结果数据都经过Callback函数处理,在Stream销毁前,需要调用一次svp_acl_rt_synchronize_device接口。

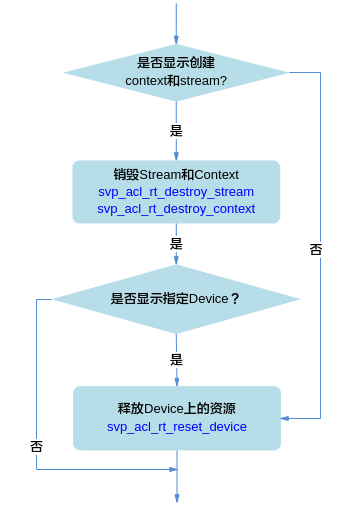

运行管理资源释放¶

图 1 运行管理资源释放流程

释放运行管理资源时,需按顺序依次释放:Stream、Context、Device。

显式创建Context和Stream时,需调用svp_acl_rt_destroy_stream接口释放Stream,再调用svp_acl_rt_destroy_context接口释放Context。若显式调用svp_acl_rt_set_device接口指定运算的Device时,还需调用svp_acl_rt_reset_device接口释放Device上的资源。

不显式创建Context和Stream时,仅需调用svp_acl_rt_reset_device接口释放Device上的资源。

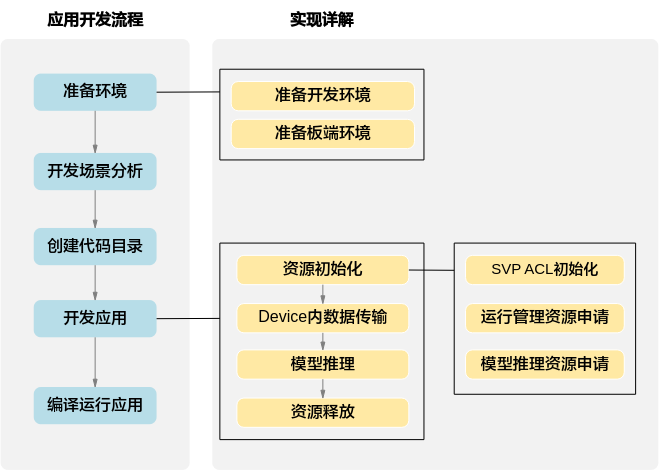

开发流程¶

图 1 开发流程(不包含数据预处理)

准备环境,包括开发环境和板端环境。

开发场景分析。

根据开发场景分析涉及哪些功能(例如,数据传输、模型推理等)的开发,确定功能后,再明确涉及的命令或接口,请参见“开发场景分析”。

创建代码目录。

在开发应用前,您需要先创建目录,存放代码文件、编译脚本、测试图片数据、模型文件等,请参见“创建代码目录”。

开发应用。

资源初始化,包括SVP ACL初始化、运行管理资源申请、模型推理资源申请等,请参见“资源初始化”。

使用SVP ACL接口开发应用时,必须先调用svp_acl_init接口进行SVP ACL初始化,否则可能会导致后续系统内部资源初始化出错,进而导致其它业务异常。

数据传输,请参见“读入图片数据”。

执行模型推理。请参见“模型推理”。

模型推理结束后,需及时释放相关资源。

若需要处理模型推理的结果,还需要进行数据后处理,例如对于图片分类应用,通过数据后处理从推理结果中查找最大置信度的类别标识。

所有数据处理结束后,需及时释放运行管理资源。

编译运行应用,包括模型转换、编译代码、运行应用,请参见“编译及运行应用”。

准备环境¶

准备开发环境¶

您需要参见《驱动和开发环境安装指南》安装开发环境,获取以下文件:

从“SVP ACLlib组件的安装目录/acllib/include/acl”目录下获取调用SVP ACL接口所需的头文件。

从“SVP ACLlib组件的安装目录/acllib/lib64/stub”目录下获取编译SVP ACL接口所需的库文件。

在安装开发环境后,您需要参见《驱动和开发环境安装指南》中的“安装后处理 ”章节安装交叉编译器,并配置对应环境变量。

须知:

须知:本文以如下安装路径示例来说明操作步骤,实际编译、运行应用前,请务必获取这些组件的实际安装路径,以便后续操作时使用,其中,$HOME表示安装用户的家目录: 以非root用户安装ACLlib组件安装包,安装路径示例为$HOME/acl,在该路径下,包括“acllib”目录。

本文中的操作步骤(包括模型转换、编译代码等)需以运行用户登录开发环境后再执行,请务必获取各组件的运行用户,以便后续操作时使用。

用户使用export命令在当前终端窗口下声明环境变量,关闭Shell终端或切换用户时环境变量失效。

准备运行环境¶

如果您需要运行应用,需完成板端环境的配置、软件包的部署等,请参见《驱动和开发环境安装指南》。

板端环境的操作系统为Linux时,在部署与调试后,使用过程中,若板端环境上的空间不足时,您可以使用mount命令将NFS服务器上的目录挂载到板端环境的指定目录。

以root用户登录Linux服务器(Ubuntu操作系统),安装NFS服务并配置共享目录。

确保环境连网且源可用的前提下,安装NFS服务,可参考如下命令安装,如果安装过程中提示已安装NFS服务,则无需重复安装:

apt-get install nfs-kernel-server在“/etc/exports”文件中配置共享目录,配置完成后,执行/etc/init.d/nfs-kernel-server restart命令重启NFS服务使配置生效。可参考如下配置段(添加在文件的末尾),斜体部分请根据实际情况替换,服务器绝对路径表示Linux服务器的共享目录,如不存在,请提前创建。

服务器绝对路径 *(rw,sync,root_squash,anonuid=id*,anongid=gid*)命令示例如下,其中,path表示板端环境上的目录,需根据实际情况修改,例如:/root。

mount -t nfs -o nolock,tcp NFS服务器IP地址:服务器绝对路径 path

开发首个应用¶

开发场景分析¶

开发场景¶

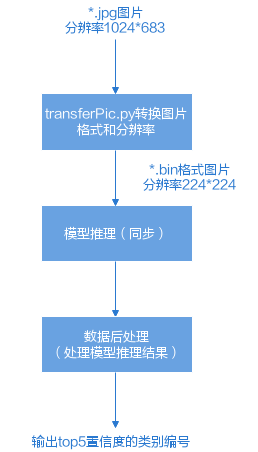

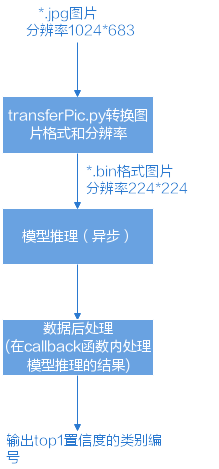

开发图片分类应用,对2张分辨率为1024*683的*.jpg图片分类。

场景分析¶

您可从以下几方面入手分析该应用需包含哪些功能,这些功能点对应哪些SVP ACL接口。

场景列表 |

实现分析 |

涉及的命令或关键接口 |

|---|---|---|

模型推理 |

本文介绍的场景是图片分类,因此需要选取开源的分类网络,此处选择的是Caffe resnet-50网络,将开源的resnet-50网络转换为适配图像分析引擎的离线模型(*.om文件),使用该离线模型推理图片所属的类别。 resnet-50网络对输入图片宽高的要求为224*224,且要求输入图片格式为RGB。但当前输入图片是*.jpg格式,因此下文的样例中提供了一个Python脚本先转换图片。 |

|

创建代码目录¶

在开发应用前,您需要先创建目录,存放代码文件、编译脚本、测试图片数据、模型文件等。

以开发环境的安装用户,在开发环境的任意目录下创建存放应用代码的目录,如下仅是示例,可参考:

├App名称

├── caffe_model //该目录下存放模型转换相关的文件

│ ├── xxx.caffemodel

├── model //该目录下存放转化后的om模型

│ ├── xxx.om

├── data

│ ├── xxx.jpg //原始测试数据

├── inc //该目录下存放声明函数的头文件

│ ├── xxx.h

├── out //该目录下存放输出结果

├── src //该目录下存放系统初始化的配置文件、编译脚本、函数的实现文件

│ ├── xxx.json //系统初始化的配置文件

│ ├── CMakeLists.txt //编译脚本

│ ├── xxx.cpp //实现文件

开发应用¶

资源初始化¶

SVP ACL初始化¶

基本原理:必须调用svp_acl_init接口初始化SVP ACL,配置文件内容为json格式,当前支持以下配置。

dump信息配置,示例、配置说明及约束请参见《ATC工具使用指南》“online_model_type”章节。默认不启动dump配置。

说明: 如果当前的默认配置已满足需求,无需修改,可向svp_acl_init接口中传入NULL,或者可将配置文件配置为空json串(即配置文件中只有{})。 向svp_acl_init接口中传入空指针的示例如下: svp_acl_error ret = svp_acl_init(NULL);

示例代码:可以从acl_resnet50样例中查看完整样例代码。

调用接口后,增加了异常处理的分支,同时通过ERROR_LOG记录报错日志、通过INFO_LOG记录各动作的提示日志,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

//初始化基本配置。

//此处的..表示相对路径,相对可执行文件所在的目录

//例如,编译出来的可执行文件存放在out目录下,此处的..就表示out目录的上一级目录

const char * acl_config_path = "../src/acl.json";

svp_acl_error ret = svp_acl_init(acl_config_path);

//......

运行管理资源申请(单进程+单线程+单Stream)¶

多线程、多Stream的场景请参见Stream管理。

基本原理:需要按顺序依次申请如下资源:Device、Context、Stream,确保可以使用这些资源执行运算、管理任务。

关于Context和Stream

显式创建Context时,调用svp_acl_rt_create_context接口,此时需显式调用svp_acl_rt_destroy_context接口释放。

显式创建Stream时,调用svp_acl_rt_create_stream接口,此时需显式调用svp_acl_rt_destroy_stream接口释放。

如果不显式创建Context和Stream,您可以使用svp_acl_rt_set_device接口隐式创建的默认Context和默认Stream,但默认Context和默认Stream存在如下限制:

一个Device对应一个默认Context,默认Context不能通过svp_acl_rt_destroy_context接口来释放。

一个Device对应一个默认Stream,默认Stream不能通过svp_acl_rt_destroy_stream接口来释放。默认Stream作为接口入参时,直接传NULL。

关于单进程、单线程、单Stream场景

单进程:一个应用程序对应一个进程。

单线程:不显式创建多个线程时,默认只有一个线程。

单Stream:整个开发的过程中使用同一个Stream。

对于同一个Stream中的异步任务,SVP ACL会按照应用程序中任务的顺序执行任务,确保异步任务执行的顺序。

示例代码:可以从acl_resnet50样例中查看完整样例代码。

调用接口后,增加了异常处理的分支,同时通过ERROR_LOG记录报错日志、通过INFO_LOG记录各动作的提示日志,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

//1.初始化变量

extern bool g_is_device;

//......

//2.指定运算的Device,SoC场景下,当前只有一个Device

ret = svp_acl_rt_set_device(device_id);

//3.显式创建一个Context,用于管理Stream对象

ret = svp_acl_rt_create_context(&context, device_id);

//4.显式创建一个Stream

//用于维护一些异步操作的执行顺序,确保按照应用程序中的代码调用顺序执行任务

ret = svp_acl_rt_create_stream(&stream);

//5.获取当前svp_acl软件栈的运行模式,根据不同的运行模式,后续的接口调用方式不同

//SoC场景下,该接口的查询结果为SVP_ACL_DEVICE,表示svp_acl软件栈运行在SoC的CPU上,只需申请SoC上的内存

svp_acl_rt_run_mode run_mode;

ret = svp_acl_rt_get_run_mode(&run_mode);

g_is_device = (run_mode == SVP_ACL_DEVICE);

//......

模型推理资源申请¶

基本原理:在模型推理前,需要从离线模型文件(适配SoC的离线模型)中加载模型数据到内存中。

关于模型转换

在模型加载前,需要将第三方网络(例如,Caffe ResNet-50网络)转换为适配SoC的离线模型,请参见《ATC工具使用指南》。

关于模型加载

加载模型数据方式如下:

svp_acl_mdl_load_from_mem:从内存加载离线模型数据,由系统内部管理内存。

关于模型的输入、输出数据

svp_acl_mdl_dataset主要用于描述模型推理时的输入数据/输出数据,模型可能存在多个输入/多个输出,每个输入/输出的内存地址、内存大小用svp_acl_data_buffer类型的数据来描述。

示例代码:可以从acl_resnet50样例中查看完整样例代码。

以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

//1.初始化变量。

//此处的..表示相对路径,相对可执行文件所在的目录

//例如,编译出来的可执行文件存放在out目录下,此处的..就表示out目录的上一级目录

const char* om_model_path = "../model/resnet50.om"

//......

//2.申请用于存储.om文件内存,model_mem_size为.om文件大小。

ret = svp_acl_rt_malloc(&model_mem_ptr, model_mem_size, SVP_ACL_MEM_MALLOC_HUGE_FIRST);

//......

//3.加载离线模型文件(适配SoC的离线模型)。

//模型加载成功,返回标识模型的ID。

ret = svp_acl_mdl_load_from_mem(model_mem_ptr, model_mem_size, &model_id);

//4.根据5中加载成功的模型的ID,获取该模型的描述信息。

// model_desc为svp_acl_mdl_desc类型。

model_desc = svp_acl_mdl_create_desc();

ret = svp_acl_mdl_get_desc(model_desc, model_id);

//5.创建svp_acl_model_dataset类型的数据,描述模型推理的输出。

//output为svp_acl_mdl_dataset类型

output = svp_acl_mdl_create_dataset();

//6.1 获取模型的输出个数.

size_t output_size = svp_acl_mdl_get_num_outputs(model_desc);

//6.2 循环为每个输出申请内存,并将每个输出添加到svp_acl_model_dataset类型的数据中.

for (size_t i = 0; i < output_size; ++i) {

size_t buffer_size = svp_acl_mdl_get_output_size_by_index(model_desc, i);

void *output_buffer = nullptr;

svp_acl_error ret = svp_acl_rt_malloc(&output_buffer, buffer_size, SVP_ACL_MEM_MALLOC_NORMAL_ONLY);

svp_acl_data_buffer* output_data = svp_acl_create_data_buffer(output_buffer, buffer_size);

ret = svp_acl_mdl_add_dataset_buffer(output, output_data);

}

//......

读入图片数据¶

基本原理:

根据“运行管理资源申请(单进程+单线程+单Stream)”中svp_acl_rt_get_run_mode接口的查询结果(SVP_ACL_DEVICE,表示软件栈运行在SoC的图像分析引擎上),在自定义函数ReadBinFile内部,直接调用svp_acl_rt_malloc申请Device上的内存,再调用C++标准库的read函数将图片数据读入Device的内存中。

读入图片数据(即将输入图片数据传输到Device上,用于推理)。

示例代码:可以从acl_resnet50样例中查看完整样例代码。

以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include <iostream>

#include <fstream>

#include <cstring>

#include "acl/svp_acl.h"

//......

//以下数据用于描述图片的路径及图片名称picName。

string testFile[] = {

"../data/dog1_1024_683.bin",

"../data/dog2_1024_683.bin"

};

//循环处理每张图片

for (size_t index = 0; index < sizeof(testFile) / sizeof(testFile[0]); ++index) {

//自定义函数,调用C++标准库std::ifstream中的函数读取图片文件。

//并输出图片文件占用的内存大小fileSize,返回值为图片文件的内存地址inputBuff。

void *inputBuff = nullptr;

uint32_t fileSize = 0;

auto ret = Utils::ReadBinFile(fileName, inputBuff, fileSize);

//TODO:模型推理

}

//......

模型推理¶

基本原理:同步执行模型推理。模型推理结束后,需及时释放相关资源。

关于模型推理

调用svp_acl_mdl_execute接口实现同步模型推理,该接口的入参之一是模型ID,在模型推理资源申请阶段,如果加载模型成功,则会返回标识模型的ID。

关于模型输出数据的处理

示例代码中的代码逻辑是:获取模型推理的输出数据,将输出数据转换为float类型后,再输出其中top5置信度的类别编号。

关于资源释放

svp_acl_mdl_dataset主要用于描述模型推理时的输入数据、输出数据,模型可能存在多个输入、多个输出,每个输入/输出的内存地址、内存大小用svp_acl_data_buffer类型的数据来描述。在模型推理结束后,需及时调用svp_acl_destroy_data_buffer接口和svp_acl_mdl_destroy_dataset接口释放描述模型输入的数据,且先调用svp_acl_destroy_data_buffer接口,再调用svp_acl_mdl_destroy_dataset接口。如果存在多个输入,需调用多次svp_acl_destroy_data_buffer接口。

在模型推理结束后,还需要通过svp_acl_mdl_unload接口卸载模型。

示例代码¶

您可以从acl_resnet50样例中查看完整样例代码。

调用接口后,增加了异常处理的分支,同时通过ERROR_LOG记录报错日志、通过INFO_LOG记录各动作的提示日志,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include <iostream>

#include <map>

#include <sstream>

#include <algorithm>

#include "acl/svp_acl.h"

//......

//以下数据用于描述图片的路径及图片名称picName。

string testFile[] = {

"../data/dog1_1024_683.bin",

"../data/dog2_1024_683.bin"

};

//循环处理每张图片

for (size_t index = 0; index < sizeof(testFile) / sizeof(testFile[0]); ++index) {

//1. 创建模型推理的输入数据

//创建svp_acl_mdl_dataset类型的数据input_,用于描述模型推理时的输入数据(图片数据集)

//输入的内存地址、内存大小用svp_acl_data_buffer类型的数据来描述

input_ = svp_acl_mdl_create_dataset();

//示例中的模型只有1个输入,将“读入图片数据”阶段的图片数据作为模型推理的输入

//inputDataBuffer表示图片数据在Device中的内存,bufferSize表示内存大小

svp_acl_data_buffer* inputData = svp_acl_create_data_buffer(inputDataBuffer, bufferSize);

svp_acl_error ret = svp_acl_mdl_add_dataset_buffer(input_, inputData);

//2. 执行模型推理

//modelId_表示模型ID,在“模型推理资源初始化”时成功加载模型后,会返回标识模型的ID

//output_表示模型推理的输出数据,在“模型推理资源初始化”时已定义

svp_acl_error ret = svp_acl_mdl_execute(modelId_, input_, output_);

//获取模型推理的输出,做数据后处理,输出top5置信度的类别编号

for (size_t i = 0; i < svp_acl_mdl_get_dataset_num_buffers (output_); ++i) {

//获取每个输出的内存地址和内存大小

svp_acl_data_buffer* dataBuffer = svp_acl_mdl_get_dataset_buffer(output_, i);

void* data = svp_acl_get_data_buffer_addr(dataBuffer);

size_t len = svp_acl_get_data_buffer_size(dataBuffer);

//将内存中的数据转换为float类型

float *outData = NULL;

outData = reinterpret_cast<float*>(data);

//屏显每张图片的top5置信度的类别编号

map<float, int, greater<float> > resultMap;

for (int j = 0; j < len / sizeof(float); ++j) {

resultMap[*outData] = j;

outData++;

}

int cnt = 0;

for (auto it = resultMap.begin(); it != resultMap.end(); ++it) {

// print top 5

if (++cnt > 5) {

break;

}

INFO_LOG("top %d: index[%d] value[%lf]", cnt, it->second, it->first);

}

//3. 模型推理结束后,释放模型推理的输入内存picDevBuffer

svp_acl_rt_free(picDevBuffer);

//4. 释放资源

//如果模型存在多个输入,则需要多次调用svp_acl_destroy_data_buffer释放描述每个输入的svp_acl_mdl_dataset类型数据

for (size_t i = 0; i < svp_acl_mdl_get_dataset_num_buffers(input_); ++i) {

svp_acl_data_buffer* dataBuffer = svp_acl_mdl_get_dataset_buffer(input_, i);

void* data = svp_acl_get_data_buffer_addr(dataBuffer);

(void)svp_acl_rt_free(data);

svp_acl_destroy_data_buffer(dataBuffer);

}

svp_acl_mdl_destroy_dataset(input_);

//......

}

//TODO:释放运行管理资源

运行管理资源释放与SVP ACL去初始化¶

基本原理:

所有数据处理都结束后,需要释放运行管理资源,包括Stream、Context、Device。释放资源时,需要按顺序释放,先释放Stream,再释放Context,最后再释放Device。

如果使用默认Stream,则不能通过svp_acl_rt_destroy_stream接口来释放。

如果使用默认Context,则不能通过svp_acl_rt_destroy_context接口来释放。

默认Context、默认Stream,是在调用svp_acl_rt_reset_device接口后自动释放。

调用svp_acl_finalize接口实现SVP ACL去初始化。

示例代码:可以从acl_resnet50样例中查看完整样例代码。

以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

svp_acl_error ret = svp_acl_rt_destroy_stream(stream);

ret = svp_acl_rt_destroy_context(context);

ret = svp_acl_rt_reset_device(device_id);

ret = svp_acl_finalize();

//......

编译及运行应用¶

编译运行应用的步骤,请参见基于Caffe ResNet-50网络实现图片分类(同步推理)。

相关注意点:

模型转换,详细说明请参见《ATC工具使用指南》。

编译代码时,编译脚本的修改点如下。

您可以从acl_resnet50样例中获取编译脚本CMakeLists.txt,在该编译脚本的基础上修改如下参数。

include_directories:添加头文件所在的目录。

示例如下:

include_directories( directoryPath1 directoryPath2 )

link_directories:添加库文件所在的目录。

示例如下:

link_directories( directoryPath3 directoryPath4 )

add_executable:修改可执行文件的名称(例如:main)、添加*.cpp文件所在的目录。

示例如下:

add_executable(main directoryPath5 directoryPath6)

target_link_libraries:修改可执行文件的名称(与 add_executable中保持一致)、添加可执行文件依赖的库文件。

示例如下:

target_link_libraries(main svp_acl libName1 libName2)

依赖的库文件与接口所在的头文件有关,具体对应关系如下:

表 1 头文件与库文件的对应关系

头文件 |

库文件 |

|---|---|

Acllib组件的安装目录/acllib/include/acl/svp_acl_base.h |

Acllib组件的安装目录/acllib/lib64/stub/libsvp_acl.so |

Acllib组件的安装目录/acllib/include/acl/svp_acl.h |

|

Acllib组件的安装目录/acllib/include/acl/svp_acl_mdl.h |

|

Acllib组件的安装目录/acllib/include/acl/svp_acl_rt.h |

|

Acllib组件的安装目录/acllib/include/acl/svp_acl_ext.h |

|

Acllib组件的安装目录/acllib/include/acl/svp_acl_prof.h |

说明:

编译通过后,运行应用时,通过配置环境变量,应用会链接到运行环境上“Acllib组件的安装目录/acllib/lib64”目录下的*.so库,运行时会自动链接到依赖其它组件的*.so库。

编译基于SVP ACL接口的代码逻辑时,请按照引用的头文件,依赖对应的so文件,引用多余的so文件可能导致后续版本升级时存在兼容性问题。 编译选项修改可执行文件的名称(与 add_executable保持一致),以及可执行文件的安装目录。 示例如下,表示main安装在${CMAKE_INSTALL_PREFIX}/out目录下,${CMAKE_INSTALL_PREFIX}变量定义的路径是相对路径,相对cmake命令执行的路径:

set(CMAKE_RUNTIME_OUTPUT_DIRECTORY "../../../out") install(TARGETS main DESTINATION ${CMAKE_RUNTIME_OUTPUT_DIRECTORY})

关于cmake参数的详细介绍,请参见https://cmake.org/cmake/help/latest/guide/tutorial/index.html,选择对应的版本后查看参数。

运行可执行文件时,需将SVP ACL初始化配置文件(acl.json)所在的目录、可执行文件所在的目录、测试图片所在的目录、*.om文件所在的目录都上传到板端环境的同一个目录下。

如果在SVP ACL初始化阶段,在svp_acl_init接口中传入空指针,则无需将SVP ACL初始化配置文件(acl.json)所在的目录上传到板端环境。

开发典型功能点的介绍¶

Stream管理¶

原理介绍¶

在SVP ACL中,Stream是一个任务队列,应用程序通过Stream来管理任务的并行,一个Stream内部的任务保序执行,即Stream根据发送过来的任务依次执行;不同Stream中的任务并行执行。一个默认Context下会挂一个默认Stream,如果不显式创建Stream,可使用默认Stream。默认Stream作为接口入参时,直接传NULL。

单线程单Stream¶

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

//显式创建一个Stream

svp_acl_rt_stream stream;

svp_acl_rt_create_stream(&stream);

uint32_t model_id = 0;

//调用触发任务的接口,例如异步模型推理,任务下发在stream1

svp_acl_mdl_dataset *input;

svp_acl_mdl_dataset *output;

svp_acl_mdl_execute_async(model_id, input, output, stream);

//调用svp_acl_rt_synchronize_stream接口,阻塞应用程序运行,直到指定Stream中的所有任务都完成。

svp_acl_rt_synchronize_stream(stream);

//Stream使用结束后,显式销毁Stream

svp_acl_rt_destroy_stream(stream);

//......

单线程多Stream¶

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

int32_t device_id = 0 ;

uint32_t model_id1 = 0;

uint32_t model_id2 = 1;

svp_acl_rt_context context;

svp_acl_rt_stream stream1;

svp_acl_rt_stream stream2;

//如果只创建了一个Context,线程默认将这个Context作为线程当前的Context;

//如果是多个Context,则需要调用svp_acl_rt_set_current_context接口设置当前线程的Context

svp_acl_rt_create_context(&context, device_id);

svp_acl_rt_create_stream(&stream1);

//调用触发任务的接口,例如异步模型推理,任务下发在stream1

svp_acl_mdl_dataset *input1;

svp_acl_mdl_dataset *output1;

svp_acl_mdl_execute_async(model_id1, input1, output1, stream1);

svp_acl_rt_create_stream(&stream2);

//调用触发任务的接口,例如异步模型推理, 任务下发在stream2

svp_acl_mdl_dataset *input2;

svp_acl_mdl_dataset *output2;

svp_acl_mdl_execute_async(model_id2, input2, output2, stream2);

// 流同步

svp_acl_rt_synchronize_stream(stream1);

svp_acl_rt_synchronize_stream(stream2);

//释放资源

svp_acl_rt_destroy_stream(stream1);

svp_acl_rt_destroy_stream(stream2);

svp_acl_rt_destroy_context(context);

//....

多线程多Stream¶

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

void run_thread(svp_acl_rt_stream stream) {

int32_t device_id =0 ;

svp_acl_rt_context context;

//如果只创建了一个Context,线程默认将这个Context作为线程当前的Context;

//如果是多个Context,则需要调用svp_acl_rt_set_current_context接口设置当前线程的Context

svp_acl_rt_create_context(&context, device_id);

svp_acl_rt_create_stream(&stream);

//调用触发任务的接口

//....

//释放资源

svp_acl_rt_destroy_stream(stream);

svp_acl_rt_destroy_context(context);

}

svp_acl_rt_stream stream1;

svp_acl_rt_stream stream2;

//创建2个线程,每个线程对应一个Stream

std::thread t1(runThread, stream1);

std::thread t2(runThread, stream2);

//显式调用join函数确保结束线程

t1.join();

t2.join();

同步等待¶

原理介绍¶

SVP ACL提供以下几种同步机制:

Stream内任务的同步等待:调用svp_acl_rt_synchronize_stream接口,阻塞应用程序运行,直到指定Stream中的所有任务都完成。

Device的同步等待:调用svp_acl_rt_synchronize_device接口,阻塞应用程序运行,直到正在运算中的Device完成运算。多Device场景下,调用该接口等待的是当前Context对应的Device。

关于Stream内任务的同步等待¶

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

//显式创建一个Stream

svp_acl_rt_stream stream;

svp_acl_rt_create_stream(&stream);

uint32_t model_id = 0;

//调用触发任务的接口,例如异步模型推理,任务下发在stream1

svp_acl_mdl_dataset *input;

svp_acl_mdl_dataset *output;

svp_acl_mdl_execute_async(model_id, input, output, stream);

//调用svp_acl_rt_synchronize_stream接口,阻塞应用程序运行,直到指定Stream中的所有任务都完成。

svp_acl_rt_synchronize_stream(stream);

//Stream使用结束后,显式销毁Stream

svp_acl_rt_destroy_stream(stream);

//......

关于Device的同步等待¶

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

#include "acl/svp_acl.h"

//......

//指定device

svp_acl_rt_set_device(0);

//创建context

svp_acl_rt_context ctx;

svp_acl_rt_create_context(&ctx, 0);

//创建stream

svp_acl_rt_stream stream;

svp_acl_rt_create_stream(&stream);

//阻塞应用程序运行,直到正在运算中的Device完成运算

svp_acl_rt_synchronize_device();

//资源销毁

svp_acl_rt_destroy_stream(stream);

svp_acl_rt_destroy_context(ctx);

svp_acl_rt_reset_device(0);

模型推理¶

单Batch+固定shape+单模型同步推理¶

若涉及色域转换(转换图像格式)、图像归一化(减均值/乘系数)等,在模型加载前,需要先参见《ATC工具使用指南》转换模型。

在模型推理前,需要从离线模型文件(适配SoC的离线模型)中加载模型数据到内存中,并创建svp_acl_mdl_dataset类型的数据描述模型的输出。请参见模型推理资源申请。

加载模型后,再同步执行模型推理。请参见模型推理。

异步推理+callback回调处理¶

基本原理:

异步推理场景下,关键接口的调用流程如下:

调用svp_acl_init接口初始化SVP ACL。

按顺序调用svp_acl_rt_set_device**、**svp_acl_rt_create_context、svp_acl_rt_create_stream接口依次申请运行管理资源:Device、Context、Stream,确保可以使用这些资源执行运算、管理任务。

如果不显式创建Context和Stream,您可以使用svp_acl_rt_set_device接口隐式创建的默认Context和默认Stream,但默认Context和默认Stream存在如下限制:

一个Device对应一个默认Context,默认Context不能通过svp_acl_rt_destroy_context接口来释放。

一个Device对应一个默认Stream,默认Stream不能通过svp_acl_rt_destroy_stream接口来释放。默认Stream作为接口入参时,直接传NULL。

申请模型推理资源。

加载模型。

svp_acl_mdl_load_from_mem:从内存加载离线模型数据。

调用svp_acl_mdl_get_desc接口获取成功加载的模型的描述信息。

初始化内存,用于存放模型推理的输入数据、输出数据。

此处需要用户可自行定义函数实现以下关键点:

调用svp_acl_mdl_create_dataset接口创建svp_acl_mdl_dataset类型的数据(描述模型的输入/输出)。

模型可能存在多个输入/输出,调用svp_acl_create_data_buffer接口创建svp_acl_data_buffer类型的数据(描述每个输入/输出数据的内存地址、内存大小)。

模型输入数据的内存大小,根据实际读入的图片数据的大小来确定。

模型输出数据的内存大小,可调用svp_acl_mdl_get_output_size_by_index接口根据3.b中模型描述信息获取每个输出需占用的内存大小。

调用svp_acl_mdl_add_dataset_buffer接口向svp_acl_mdl_dataset中增加svp_acl_data_buffer。

执行模型异步推理和callback(用于处理模型推理的结果)。

此处需要用户可自行定义函数实现以下关键点:

创建新线程(例如t1),在线程函数内调用svp_acl_rt_process_report接口,等待指定时间后,触发回调函数(例如CallBackFunc,用于处理模型推理结果)。

调用svp_acl_rt_subscribe_report接口,指定处理Stream上回调函数(CallBackFunc)的线程(t1),回调函数需要提前创建,用于处理模型推理的结果(例如,将推理结果写入文件、从推理结果中获取topn置信度的类别标识等)。

调用svp_acl_mdl_execute_async接口执行异步模型推理。

调用svp_acl_rt_launch_callback接口,在Stream的任务队列中增加一个需要在板端环境上执行的回调函数(CallBackFunc)。

调用svp_acl_rt_synchronize_stream接口,阻塞应用程序运行,直到指定Stream中的所有任务都完成。

调用svp_acl_rt_unsubscribe_report接口,取消线程注册,Stream上的回调函数(CallBackFunc)不再由指定线程(t1)处理。

模型推理结束后,调用svp_acl_mdl_unload接口卸载模型。

所有数据处理结束后,按顺序调用svp_acl_rt_destroy_stream、svp_acl_rt_destroy_context、svp_acl_rt_reset_device接口依次释放运行管理资源,包括Stream、Context、Device。

调用svp_acl_finalize接口实现SVP ACL去初始化。

示例代码:

您可以从acl_resnet50_async样例中查看完整样例代码,以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

在acl_resnet50_async样例中:

运行可执行文件,不带参数时:

执行模型异步推理的次数默认为10次,对应代码中的g_executeTimes变量;

callback间隔默认为1,表示1次异步推理后,下发一次callback任务,对应代码中的g_callbackInterval变量;

内存池中的内存块的个数默认为10个,对应代码中的g_memoryPoolSize。

运行可执行文件,带参数时:

第一个参数表示执行模型异步推理的次数;

第二个参数表示下发callback间隔,参数值为0时表示不下发callback任务,参数值为非0值(例如m)时表示m次异步推理后下发一次callback任务;

第三个参数表示内存池中内存块的个数,内存块个数需大于等于模型异步推理的次数。用户可根据输入图片数量,来调整内存块的个数,例如有2张输入图片、内存块个数为2时,则1张图片1个内存块;例如有3张输入图片、内存块个数为10时,则执行10次循环,每(10/3取整)个内存块对应同一张图片,剩下1个内存块随机对应1张图片。内存块中存放是模型推理的输入数据、输出数据,若多个内存块对应的是同一张图片,则多个内存块中存放的是相同的输入数据、输出数据,用于输入图片少但又想模拟大量图片数据的场景。

#include "acl/svp_acl.h" //...... //1. SVP ACL初始化 //此处的..表示相对路径,相对可执行文件所在的目录 //例如,编译出来的可执行文件存放在out目录下,此处的..就表示out目录的上一级目录 const char *aclConfigPath = "../src/acl.json"; svp_acl_error ret = svp_acl_init(aclConfigPath); //2. 申请运行管理资源 extern bool g_isDevice; ret = svp_acl_rt_set_device(deviceId_); ret = svp_acl_rt_create_context(&context_, deviceId_); ret = svp_acl_rt_create_stream(&stream_); //获取当前svp_acl软件栈的运行模式,根据不同的运行模式,后续的内存申请、内存复制等接口调用方式不同 svp_acl_rt_run_mode run_mode; ret = svp_acl_rt_get_run_mode(&runMode); g_isDevice = (runMode == ACL_DEVICE); //3. 申请模型推理资源 //此处的..表示相对路径,相对可执行文件所在的目录 //例如,编译出来的可执行文件存放在out目录下,此处的..就表示out目录的上一级目录 const char* omModelPath = "../model/resnet50.om" //3.1 加载模型 //根据模型文件获取模型执行时所需的权值内存大小、工作内存大小,并申请权值内存、工作内存 ret = svp_acl_rt_malloc(&modelMemPtr_, modelMemSize_, SVP_ACL_MEM_MALLOC_NORMAL_ONLY); //加载离线模型文件,模型加载成功,返回标识模型的ID。 ret = svp_acl_mdl_load_from_mem(modelPath, &modelId_, modelMemPtr_, modelMemSize_); //3.2 根据模型的ID,获取该模型的描述信息 modelDesc_ = svp_acl_mdl_create_desc(); ret = svp_acl_mdl_get_desc(modelDesc_, modelId_); //3.3 自定义函数InitMemPool,初始化内存池,存放模型推理的输入数据、输出数据 //-----自定义函数InitMemPool内部的关键实现----- string testFile[] = { "../data/dog1_1024_683.bin", "../data/dog2_1024_683.bin" }; size_t fileNum = sizeof(testFile) / sizeof(testFile[0]); for (size_t i = 0; i < g_memoryPoolSize; ++i) { size_t index = i % (sizeof(testFile) / sizeof(testFile[0])); // model process uint32_t devBufferSize; //自定义函数GetDeviceBufferOfFile,完成以下功能: //获取Host上存放输入图片数据的内存及内存大小、将图片数据从Host传输到Device、获取Device上存放输入图片数据的内存及内存大小 void *picDevBuffer = Utils::GetDeviceBufferOfFile(testFile[index], devBufferSize); aclmdlDataset *input = nullptr; //自定义函数CreateInput,创建aclmdlDataset类型的数据input,用于存放模型推理的输入数据 Result ret = CreateInput(picDevBuffer, devBufferSize, input); svp_acl_mdl_dataset *output = nullptr; //自定义函数CreateOutput,创建svp_acl_mdl_dataset类型的数据output,用于存放模型推理的输出数据,modelDesc表示模型的描述信息 CreateOutput(output, modelDesc); { std::lock_guard<std::recursive_mutex> lk(freePoolMutex_); freeMemoryPool_[input] = output; } } //-----自定义函数InitMemPool内部的关键实现----- //4 模型推理 //4.1 创建线程tid,并将该tid线程指定为处理Stream上回调函数的线程 //其中ProcessCallback为线程函数,在该函数内调用svp_acl_rt_process_report接口,等待指定时间后,触发回调函数处理 pthread_t tid; (void)pthread_create(&tid, nullptr, ProcessCallback, &s_isExit); //4.2 指定处理Stream上回调函数的线程 svp_acl_error aclRt = svp_acl_rt_subscribe_report(tid, stream_); //4.2 创建回调函数,用户处理模型推理的结果,由用户自行定义 void ModelProcess::CallBackFunc(void *arg) { std::map<svp_acl_mdl_dataset *, svp_acl_mdl_dataset *> *dataMap = (std::map<svp_acl_mdl_dataset *, svp_acl_mdl_dataset *> *)arg; svp_acl_mdl_dataset *input = nullptr; svp_acl_mdl_dataset *output = nullptr; MemoryPool *memPool = MemoryPool::Instance(); for (auto& data : *dataMap) { ModelProcess::OutputModelResult(data.second); memPool->FreeMemory(data.first, data.second); } delete dataMap; } //4.3 自定义函数ExecuteAsync,执行模型推理 //-----自定义函数ExecuteAsync内部的关键实现----- bool isCallback = (g_callbackInterval != 0); size_t callbackCnt = 0; std::map<svp_acl_mdl_dataset *, svp_acl_mdl_dataset *> *dataMap = nullptr; svp_acl_mdl_dataset *input = nullptr; svp_acl_mdl_dataset *output = nullptr; MemoryPool *memPool = MemoryPool::Instance(); for (uint32_t cnt = 0; cnt < g_executeTimes; ++cnt) { if (memPool->mallocMemory(input, output) != SUCCESS) { ERROR_LOG("get free memory failed"); return FAILED; } //执行异步推理 svp_acl_error ret = svp_acl_mdl_execute_async(modelId_, input, output, stream_); if (isCallback) { if (dataMap == nullptr) { dataMap = new std::map<svp_acl_mdl_dataset *, svp_acl_mdl_dataset *>; if (dataMap == nullptr) { ERROR_LOG("malloc list failed, modelId is %u", modelId_); memPool->FreeMemory(input, output); return FAILED; } } (*dataMap)[input] = output; callbackCnt++; if ((callbackCnt % g_callbackInterval) == 0) { //在Stream的任务队列中增加一个需要在Host上执行的回调函数 ret = svp_acl_rt_launch_callback(CallBackFunc, (void *)dataMap, SVP_ACL_CALLBACK_BLOCK, stream_); if (ret != ACL_SUCCESS) { ERROR_LOG("launch callback failed, index=%zu", callbackCnt); memPool->FreeMemory(input, output); delete dataMap; return FAILED; } dataMap = nullptr; } } } //-----自定义函数ExecuteAsync内部的关键实现----- //4.4 对于异步推理,需阻塞应用程序运行,直到指定Stream中的所有任务都完成 svp_acl_rt_synchronize_stream(stream_); //4.5 取消线程注册,Stream上的回调函数不再由指定线程处理 aclRt = svp_acl_rt_unsubscribe_report(static_cast<uint64_t>(tid), stream_); s_isExit = true; (void)pthread_join(tid, nullptr); //5 释放运行管理资源 svp_acl_error ret = svp_acl_rt_destroy_stream(stream_); ret = svp_acl_rt_destroy_context(context_); ret = svp_acl_rt_reset_device(deviceId_); //6 SVP ACL去初始化 ret = svp_acl_finalize(); //......

多模型推理¶

多模型推理的基本流程与单模型类似,请参见单Batch+固定shape+单模型同步推理。

多模型推理与单模型推理的不同点如下:

关于模型加载,如果涉及多个模型,需调用多次模型加载接口。

svp_acl_mdl_load_from_mem:从内存加载离线模型数据。

关于模型推理,如果涉及多个模型,需调用多次模型推理接口。

调用svp_acl_mdl_execute接口实现同步模型推理。

带cache属性的内存管理¶

基本原理:

通过svp_acl_rt_malloc_cached接口申请的内存支持cache缓存,对于频繁使用的内存,建议使用本接口分配内存,这样可以提高cpu的读写效率,提升系统性能,但需要用户处理cpu与硬件设备(如图像分析引擎)之间的数据一致性问题,SVP ACL提供了svp_acl_rt_mem_flush接口将cache中的数据刷新到ddr中,从而确保硬件设备(如图像分析引擎)可以从ddr中获取最新数据进行处理,SVP ACL还提供了svp_acl_rt_mem_invalidate接口将cache中的数据置为无效(如果cache被CPU写操作,调用该接口功能会将数据刷到ddr),从而确保cpu可以获取到ddr中的经图像分析引擎处理后的结果数据。

如果任务(例如,模型加载)不涉及cpu与硬件设备(如图像分析引擎)之间的数据交互,则不涉及两者之间的数据一致性问题,因此就不需要调用svp_acl_rt_mem_flush接口和svp_acl_rt_mem_invalidate接口。

示例代码:

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

示例中,运行管理资源申请与释放请参见运行管理资源申请和运行管理资源释放,模型加载的接口调用流程请参见模型加载,模型推理的接口调用流程、准备模型推理的输入/输出数据的接口调用流程请参见模型执行。

//1.申请运行管理资源,包括设置用于计算的Device、创建Context、创建Stream

//......

//2.模型加载,加载成功后,返回标识模型的model_id

//......

//3.创建svp_acl_mdl_dataset类型的数据,用于描述模型的输入数据input、输出数据output

void *input_dev_buffer = null;

void *output_dev_buffer = null;

size_t input_size;

size_t output_size;

//3.1 申请支持cache缓存的内存:input_dev_buffer用于存放模型推理的输入数据

svp_acl_error ret = svp_acl_rt_malloc_cached(&input_dev_buffer, input_size, SVP_ACL_MEM_MALLOC_NORMAL_ONLY);

svp_acl_mdl_dataset *input = svp_acl_mdl_create_dataset();

svp_acl_data_buffer* input_data = svp_acl_create_data_buffer(input_dev_buffer, input_size);

ret = svp_acl_mdl_add_dataset_buffer(input, input_data);

//将输入数据读入内存中,该自定义函数ReadFile由用户实现

read_file(file_name, input_dev_buffer, input_size);

//3.2 申请支持cache缓存的内存:output_dev_buffer用于存放模型推理的输出数据

ret = svp_acl_rt_malloc_cached(&output_dev_buffer, output_size, SVP_ACL_MEM_MALLOC_NORMAL_ONLY);

svp_acl_mdl_dataset *output = svp_acl_mdl_create_dataset();

svp_acl_data_buffer* output_data = svp_acl_create_data_buffer(output_dev_buffer,

size);

ret = svp_acl_mdl_add_dataset_buffer(output, output_data);

//4.把对应cache中的数据刷新到ddr

//示例以获取第一个输入为例,如果有多个输入,可调用svp_acl_mdl_get_dataset_num_buffers接口获取输入个数

svp_acl_data_buffer *input_data_buffer = svp_acl_mdl_get_dataset_buffer(input, 0);

void *input_data_buffer_addr = svp_acl_get_data_buffer_addr(input_data_buffer);

size_t input_data_buffer_size = svp_acl_get_data_buffer_size(input_data_buffer);

ret = svp_acl_rt_mem_flush(input_data_buffer_addr, input_data_buffer_size);

//5.执行模型

ret = svp_acl_mdl_execute(model_id, input, output);

//6.执行svp_acl_rt_mem_invalidate接口,把对应cache中的数据置为无效,确保cpu获取到的是ddr中的数据

//示例以获取第一个输出为例,如果有多个输出,可调用svp_acl_mdl_get_dataset_num_buffers接口获取输出个数

svp_acl_data_buffer *out_data_buffer = svp_acl_mdl_get_dataset_buffer(output, 0);

void *output_data_buffer_addr = svp_acl_get_data_buffer_addr(out_data_buffer);

size_t output_data_buffer_size = svp_acl_get_data_buffer_size(out_data_buffer);

ret = svp_acl_rt_mem_invalidate(output_data_buffer_addr, output_data_buffer_size);

//7.处理模型推理结果

//TODO

//8.释放内存

svp_acl_rt_free(input_dev_buffer);

svp_acl_rt_free(output_dev_buffer);

//9.释放描述模型输入/输出信息、内存等资源,卸载模型

//......

//10.释放运行管理资源

//......

推理使用模式识别CPU算子¶

基本原理:

SoC推理场景下,如果模型中有模式识别 Core不支持的算子,需要通过模式识别CPU算子来实现,这时,异步推理场景下可以调用svp_acl_ext_process_aacpu_task接口来接收模式识别CPU算子并在CPU上执行,同步推理场景下无需用户做特殊处理。下面就异步推理关于该接口的使用方式进行进一步介绍。

模式识别CPU算子在CPU侧执行时可能会引入一些问题,因此用户需要关注以下几点:

为了不影响整个推理业务,需要创建模式识别CPU工作线程对模式识别CPU算子进行处理,确保模式识别CPU算子处理和推理业务同时在CPU侧运行,且可保证各自的执行效率。

需要用户在模式识别CPU工作线程内,调用svp_acl_ext_process_aacpu_task接口来接收模式识别CPU算子并执行。

用户场景差异比较大,需要根据自己业务需求来部署模式识别CPU工作线程,例如线程数量,是否绑核。

示例代码:

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

示例中,异步推理流程请参见异步推理+callback回调处理 。

//1.实现模式识别CPU工作线程处理函数 static bool thread_exit_flag = false; void *cpu_func_async_test(void *param) { while (thread_exit_flag == false) { svp_acl_ext_process_aacpu_task(1000); } return NULL; } //2.主线程创建模式识别CPU工作线程 static pthread_t g_tid; pthread_create(&g_tid, NULL, cpu_func_async_test, NULL); //3.异步推理流程 //...... //4.释放线程 thread_exit_flag = true; pthread_join(g_tid, NULL);

须知:

编译代码的时候,需要匹配对应的头文件svp_acl_ext.h,目前文件(分别在板端SDK版本的smp/a55_linux/mpp/out路径的include/svp_nnn和lib/svp_nnn目录下,其他解决方案类似参考)。

须知:

编译代码的时候,需要匹配对应的头文件svp_acl_ext.h,目前文件(分别在板端SDK版本的smp/a55_linux/mpp/out路径的include/svp_nnn和lib/svp_nnn目录下,其他解决方案类似参考)。

Profiling性能数据采集¶

基本原理:

该章节下的接口用于Profiling采集性能数据,实现方式支持以下两种:

方式一:将采集到的Profiling数据写入文件,再使用Profiling工具解析该文件。

方式二:将采集到的Profiling数据解析后写入管道,由用户读入内存,再由用户调用ACL的接口获取性能数据。

实现方式详细说明请参考“功能及约束说明”。

示例代码1:

调用接口后,需增加异常处理的分支,并记录报错日志、提示日志,此处不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

示例中,运行管理资源申请与释放、模型加载的接口调用流程、模型推理的接口调用流程、准备模型推理的输入/输出数据的接口调用流程请参见异步推理+callback回调处理。

//1.SVP ACL资源初始化、模型加载、数据创建

//2.创建管道(UNIX操作系统下需要引用C++标准库头文件unistd.h),用于读取以及写入模型订阅的数据

int sub_fd[2];

// 读管道指针指向sub_fd[0],写管道指针指向sub_fd[1]

pipe(sub_fd);

//3.创建模型订阅的配置并且进行模型订阅

svp_acl_prof_subscribe_config *config = svp_acl_prof_create_subscribe_config(1, 0, &sub_fd[1]);

//模型订阅需要传入模型的model_id

svp_acl_prof_model_subscribe(model_id, config);

//4.实现管道读取订阅数据的函数

//4.1 自定义函数,实现从用户内存中读取订阅数据的函数

void get_model_info(void *data, uint32_t len) {

uint32_t op_number = 0;

uint32_t data_len = 0;

//通过SVP ACL接口读取算子信息个数

svp_acl_prof_get_op_num(data, len, &op_number);

//遍历用户内存的算子信息

for (int32_t i = 0; i < op_number; i++){

//获取算子的模型id

uint32_t model_id = svp_acl_prof_get_model_id(data,len, i);

//获取算子的类型名称长度

size_t op_type_len = 0;

svp_acl_prof_get_op_type_len(data, len, i, &op_type_len);

//获取算子的类型名称

char op_type[op_type_len];

svp_acl_prof_get_op_type(data, len, i, op_type, op_type_len);

//获取算子的详细名称长度

size_t op_name_len = 0;

svp_acl_prof_get_op_name_len(data, len, i, &op_name_len);

//获取算子的详细名称

char op_name[op_name_len];

svp_acl_prof_get_op_name(data, len, i, op_name, op_name_len);

//获取算子的执行开始时间

uint64_t op_start = svp_acl_prof_get_op_start(data, len, i);

//获取算子的执行结束时间

uint64_t op_end = svp_acl_prof_get_op_end(data, len, i);

uint64_t op_duration = svp_acl_prof_get_op_duration(data, len, i);

}

}

//4.2 自定义函数,实现从管道中读取数据到用户内存的函数

void *prof_data_read(void *fd) {

//设置每次从管道中读取的算子信息个数

uint64_t N = 10;

//获取单位算子信息的大小(Byte)

uint64_t buffer_size = 0;

svp_acl_prof_get_op_desc_size(&buffer_size);

//计算存储算子信息的内存的大小,并且申请内存

uint64_t read_buf_len = buffer_size * N;

char *read_buf = (char *)malloc(sizeof(char) * read_buf_len);

//从管道中读取数据到申请的内存中,读取到的实际数据大小data_len可能小于buffer_size * N,如果管道中没有数据,默认会阻塞直到读取到数据为止

uint32_t data_len = read(*(int*)fd, read_buf, read_buf_len);

//读取数据到read_buf成功

while (data_len > 0) {

//调用4.1实现的函数解析内存中的数据

get_model_info(read_buf, data_len);

memset(read_buf, 0, buffer_size);

data_len = read(*(int*)fd, read_buf, read_buf_len);

}

free(read_buf);

}

//5. 启动线程读取管道数据并解析

pthread_t sub_tid = 0;

pthread_create(&sub_tid, NULL, prof_data_read, &sub_fd[0]);

//6.执行模型

ret = svp_acl_mdl_execute(model_id, input, output);

//7.处理模型推理结果、释放资源、卸载模型、等待线程数据获取完毕

//8.取消订阅,释放订阅相关资源

svp_acl_prof_model_unsubscribe(model_id);

close(sub_fd[1]);

pthread_join(sub_tid, NULL);

close(sub_fd[0]);

//释放config指针

svp_acl_prof_destroy_subscribe_config(config);

//9. 释放运行管理资源,SVP ACL去初始化

//......

示例代码2:

调用接口后,需增加异常处理的分支,示例代码中不一一列举。以下是关键步骤的代码示例,不可以直接拷贝编译运行,仅供参考。

示例中,运行管理资源申请与释放、模型加载的接口调用流程、模型推理的接口调用流程、准备模型推理的输入/输出数据的接口调用流程请参见异步推理+callback回调处理。

//1.SVP ACL资源初始化、模型加载、数据创建

//2.profiling初始化

//设置数据落盘路径

const char *prof_path = "./";

svp_acl_prof_init(prof_path, strlen(prof_path));

//3.进行profiling配置

uint32_t device_id_list[1] = {0};

//创建配置结构体

svp_acl_prof_config *config = svp_acl_prof_create_config(device_id_list, 1, 0, NULL, SVP_ACL_PROF_AACORE_METRICS | SVP_ACL_PROF_AACPU);

svp_acl_prof_start(config);

//4.执行模型

ret = svp_acl_mdl_execute(model_id, input, output);

//5.处理模型推理结果、释放资源、卸载模型

//6.关闭profiling配置, 释放配置资源, 释放profiling组件资源

svp_acl_prof_stop(config);

svp_acl_prof_destroy_config(config);

svp_acl_prof_finalize();

//7.释放运行管理资源,SVP ACL去初始化.

//......

JSON文件格式:

通过svp_acl_init指定带有Profiling配置的json文件也可以实现将采集到的Profiling数据写入文件的功能,文件格式如下:

{

"profiler": {

"switch": "on",

"output": "output",

"interval": "20",

"aac_metrics": "ArithmeticUtilization",

"aacpu": "on",

"acl_api": "on"

}

}

profiler参数配置说明:

switch:Profiling开关,取值on或off。可选参数。

on表示开启Profiling,off表示关闭Profiling;如果缺失该参数或参数值不为on,则表示关闭Profiling。

output:Profiling性能数据在板端环境上的落盘路径。可选参数。

Profiling采集结束后,在该目录下生成JOB开头目录,存放Profiling采集的性能原始数据。支持配置绝对路径或相对路径(相对执行命令行时的当前路径):

绝对路径配置以“/”开头,例如:/home/output。

相对路径配置直接以目录名开始,例如:output。

如果该处设置的目录不存在,默认存放采集结果数据到应用工程可执行文件所在目录(确保安装时配置的运行用户具有该目录的读写权限)。

注意:

该参数指定的目录需要提前创建且确保安装时配置的运行用户具有读写权限。

注意:

该参数指定的目录需要提前创建且确保安装时配置的运行用户具有读写权限。interval:Profiling采集间隔,代表每interval次推理保存一次Profiling数据,此配置建议不要设置太小,否则可能由于落盘数据太慢而引起数据丢失。

_aa_c_metrics:模式识别Core采集事件,配置为ArithmeticUtilization代表采集模式识别Core性能数据,否则为不采集。

_aa_cpu:模式识别CPU采集事件,配置为on代表采集模式识别CPU性能数据,否则为不开启。

acl_api:ACL API采集事件,配置为on代表采集主要ACL API接口性能数据,否则为不开启。

注意: acl_api性能数据的内存当前配置最大值为512,表示一次采集只能最多采集512份acl_api的数据。如果一次采集超出最大份数,数据会覆盖,导致采集的api数据不准。一次采集中,加载模型/卸载模型会占据2份acl_api内存数据。

不带aacpu算子的网络,建议采集数据时,一次采集不要超过510(512 - 2)份;

带aacpu算子的网络,建议采集数据时,一次采集不要超过255((512 - 2) / 2)份。

SVP ACL API参考¶

接口列表¶

一级目录 |

二级目录或接口或数据类型 |

三级目录或接口 |

是否支持 |

|---|---|---|---|

系统配置 |

svp_acl_init |

- |

支持 |

svp_acl_finalize |

- |

支持 |

|

Device管理 |

svp_acl_rt_set_device |

- |

支持 |

svp_acl_rt_reset_device |

- |

支持 |

|

svp_acl_rt_get_device |

- |

支持 |

|

svp_acl_rt_get_run_mode |

- |

支持 |

|

svp_acl_rt_get_device_count |

- |

支持 |

|

Context管理 |

svp_acl_rt_create_context |

- |

支持 |

svp_acl_rt_destroy_context |

- |

支持 |

|

svp_acl_rt_set_current_context |

- |

支持 |

|

svp_acl_rt_get_current_context |

- |

支持 |

|

Stream管理 |

svp_acl_rt_create_stream |

- |

支持 |

svp_acl_rt_destroy_stream |

- |

支持 |

|

同步等待 |

svp_acl_rt_synchronize_device |

- |

支持 |

svp_acl_rt_synchronize_stream |

- |

支持 |

|

svp_acl_rt_subscribe_report |

- |

支持 |

|

svp_acl_rt_launch_callback |

- |

支持 |

|

svp_acl_rt_process_report |

- |

支持 |

|

svp_acl_rt_unsubscribe_report |

- |

支持 |

|

svp_acl_rt_set_op_wait_timeout |

- |

支持 |

|

内存管理 |

svp_acl_rt_malloc |

- |

支持 |

svp_acl_rt_malloc_cached |

- |

支持 |

|

svp_acl_rt_mem_flush |

- |

支持 |

|

svp_acl_rt_mem_invalidate |

- |

支持 |

|

svp_acl_rt_free |

- |

支持 |

|

svp_acl_rt_malloc_host |

- |

支持 |

|

svp_acl_rt_free_host |

- |

支持 |

|

模型加载与执行 |

svp_acl_mdl_load_from_mem |

- |

支持 |

svp_acl_mdl_execute |

- |

支持 |

|

svp_acl_mdl_execute_async |

- |

支持 |

|

svp_acl_mdl_unload |

- |

支持 |

|

svp_acl_mdl_set_dynamic_batch_size |

- |

支持 |

|

svp_acl_mdl_set_total_t |

- |

支持 |

|

svp_acl_mdl_init_dump |

- |

支持 |

|

svp_acl_mdl_set_dump |

- |

支持 |

|

svp_acl_mdl_finalize_dump |

- |

支持 |

|

svp_acl_mdl_set_config_opt |

- |

支持 |

|

svp_acl_mdl_load_with_config |

- |

支持 |

|

svp_acl_mdl_get_first_aapp_info |

- |

支持 |

|

svp_acl_mdl_get_dynamic_batch |

- |

支持 |

|

svp_acl_mdl_set_dynamic_hw_size |

- |

支持 |

|

Profiling配置 |

svp_acl_prof_init |

- |

支持 |

svp_acl_prof_start |

- |

支持 |

|

svp_acl_prof_stop |

- |

支持 |

|

svp_acl_prof_finalize |

- |

支持 |

|

svp_acl_prof_model_subscribe |

- |

支持 |

|

svp_acl_prof_model_unsubscribe |

- |

支持 |

|

svp_acl_prof_get_op_desc_size |

- |

支持 |

|

svp_acl_prof_get_op_num |

- |

支持 |

|

svp_acl_prof_get_op_type_len |

- |

支持 |

|

svp_acl_prof_get_op_type |

- |

支持 |

|

svp_acl_prof_get_op_name_len |

- |

支持 |

|

svp_acl_prof_get_op_name |

- |

支持 |

|

svp_acl_prof_get_op_start |

- |

支持 |

|

svp_acl_prof_get_op_stop |

- |

支持 |

|

svp_acl_prof_get_op_duration |

- |

支持 |

|

svp_acl_prof_get_model_id |

- |

支持 |

|

获取数据大小 |

svp_acl_data_type_size |

- |

支持 |

SoC扩展接口 |

svp_acl_ext_process_aacpu_task |

- |

支持 |

svp_acl_ext_get_mdl_aacpu_task_num |

- |

支持 |

|

svp_acl_ext_get_mdl_net_type |

- |

支持 |

|

数据类型及其操作接口 |

svp_acl_error |

- |

支持 |

svp_acl_data_type |

- |

支持 |

|

svp_acl_float16 |

- |

支持 |

|

svp_acl_format |

- |

支持 |

|

svp_acl_rt_context |

- |

支持 |

|

svp_acl_rt_stream |

- |

支持 |

|

svp_acl_mdl_io_dims |

- |

支持 |

|

svp_acl_data_buffer |

svp_acl_create_data_buffer |

支持 |

|

svp_acl_destroy_data_buffer |

支持 |

||

svp_acl_get_data_buffer_addr |

支持 |

||

svp_acl_get_data_buffer_size |

支持 |

||

svp_acl_get_data_buffer_stride |

支持 |

||

svp_acl_update_data_buffer |

支持 |

||

svp_acl_mdl_dataset |

svp_acl_mdl_create_dataset |

支持 |

|

svp_acl_mdl_destroy_dataset |

支持 |

||

svp_acl_mdl_add_dataset_buffer |

支持 |

||

svp_acl_mdl_get_dataset_num_buffers |

支持 |

||

svp_acl_mdl_get_dataset_buffer |

支持 |

||

svp_acl_mdl_desc |

svp_acl_mdl_create_desc |

支持 |

|

svp_acl_mdl_destroy_desc |

支持 |

||

svp_acl_mdl_get_desc |

支持 |

||

svp_acl_mdl_get_num_inputs |

支持 |

||

svp_acl_mdl_get_num_outputs |

支持 |

||

svp_acl_mdl_get_input_size_by_index |

支持 |

||

svp_acl_mdl_get_output_size_by_index |

支持 |

||

svp_acl_mdl_get_input_dims |

支持 |

||

svp_acl_mdl_get_output_dims |

支持 |

||

svp_acl_mdl_get_input_name_by_index |

支持 |

||

svp_acl_mdl_get_output_name_by_index |

支持 |

||

svp_acl_mdl_get_input_format |

支持 |

||

svp_acl_mdl_get_output_format |

支持 |

||

svp_acl_mdl_get_input_data_type |

支持 |

||

svp_acl_mdl_get_output_data_type |

支持 |

||

svp_acl_mdl_get_input_index_by_name |

支持 |

||

svp_acl_mdl_get_output_index_by_name |

支持 |

||

svp_acl_mdl_get_input_default_stride |

支持 |

||

svp_acl_mdl_get_output_default_stride |

支持 |

||

svp_acl_mdl_get_dynamic_hw |

支持 |

||

svp_acl_prof_config |

svp_acl_prof_create_config |

支持 |

|

svp_acl_prof_destroy_config |

支持 |

||

svp_acl_prof_subscribe_config |

svp_acl_prof_create_subscribe_config |

支持 |

|

svp_acl_prof_destroy_subscribe_config |

支持 |

||

svp_acl_mdl_config_attr |

- |

支持 |

|

svp_acl_mdl_config_handle |

svp_acl_mdl_create_config_handle |

支持 |

|

svp_acl_mdl_destroy_config_handle |

支持 |

||

svp_acl_aapp_input_format svp_acl_aapp_info |

svp_acl_mdl_get_first_aapp_info |

支持 |

系统配置¶

svp_acl_init¶

函数功能:SVP ACL初始化函数,同步接口。

约束说明:

一个进程内只能调用一次svp_acl_init接口。

使用SVP ACL接口开发应用时,必须先调用svp_acl_init接口,进行内部资源初始化,否则可能会导致业务异常。

进程退出时需要调用svp_acl_finalize接口释放内部资源。

函数原型:

svp_acl_error svp_acl_init(const char *config_path)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

config_path |

输入 |

配置文件所在的路径,包含文件名,配置文件内容为json格式(json文件内的“{”的层级最多为10,“[”的层级最多为10)。如果以下的默认配置已满足需求,无需修改,可向aclInit接口中传入NULL,或者可将配置文件配置为空json串(即配置文件中只有{})。 配置文件格式为json格式,当前支持以下配置:

|

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_finalize¶

函数功能:SVP ACL去初始化函数,用于释放进程内的SVP ACL内部管理的相关资源,同步接口。

约束说明:

用户申请的资源需要在调用svp_acl_finalize接口前通过调用对应的释放接口释放,防止未释放的资源造成内存泄露或者后续被误用而导致业务异常。

应用的进程退出前,应显式调用该接口实现SVP ACL去初始化,否则可能会导致异常,例如应用进程退出时有异常报错。

不建议在析构函数中调用svp_acl_finalize接口,否则在进程退出时可能由于单例析构顺序未知而导致进程异常退出的问题。

函数原型:

svp_acl_error svp_acl_finalize()

参数说明:无

返回值说明:返回0表示成功,返回其它值表示失败。

Device管理¶

svp_acl_rt_set_device¶

函数功能:

指定用于运算的Device,同时隐式创建默认Context,该默认Context中包含1个默认Stream,同步接口。

如果多次调用svp_acl_rt_set_device接口而不调用svp_acl_rt_reset_device接口释放本进程使用的Device资源,功能上不会有问题,因为在进程退出时也会释放本进程使用的Device资源。建议svp_acl_rt_set_device接口和svp_acl_rt_reset_device接口配对使用,在不使用Device上资源时,通过调用svp_acl_rt_reset_device接口及时释放本进程使用的Device资源。

支持以下使用场景:

在不同进程或线程中可指定同一个Device用于运算。

在某一进程中指定Device,该进程内的多个线程可共用此Device显式创建Context(svp_acl_rt_create_context接口)。

多Device场景下,可在进程中通过svp_acl_rt_set_device接口切换到其它Device。但利用Context切换(调用svp_acl_rt_set_current_context接口)来切换Device,比使用svp_acl_rt_set_device接口效率高。

函数原型:

svp_acl_error svp_acl_rt_set_device(int32_t device_id)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

device_id |

输入 |

Device ID。 用户调用svp_acl_rt_get_device_count接口获取可用的Device数量后,这个Device ID的取值范围:[0, (可用的Device数量-1)] |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_reset_device¶

函数功能:复位当前运算的Device,释放Device上的资源,包括默认Context、默认Stream以及默认Context下创建的所有Stream,同步接口。若默认Context或默认Stream下的任务还未完成,会删除任务,不再执行。

约束说明:

若要复位的Device上存在显式创建的Context、Stream,在复位前,建议遵循如下接口调用顺序,否则可能会导致业务异常。

接口调用顺序:调用svp_acl_rt_destroy_stream接口释放显式创建的Stream-->调用svp_acl_rt_destroy_context释放显式创建的Context-->调用svp_acl_rt_reset_device接口

函数原型:

svp_acl_error svp_acl_rt_reset_device(int32_t device_id)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

device_id |

输入 |

Device ID。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_get_device¶

函数功能:获取当前正在使用的Device的ID,同步接口。

约束说明:如果没有调用svp_acl_rt_set_device接口显式指定Device或没有调用svp_acl_rt_create_context接口隐式指定Device,则调用本接口时,返回错误。

函数原型:

svp_acl_error svp_acl_rt_get_device(int32_t *device_id)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

device_id |

输出 |

Device ID。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_get_run_mode¶

函数功能:获取当前svp_acl软件栈的运行模式,同步接口。

函数原型:

svp_acl_error svp_acl_rt_get_run_mode(svp_acl_rt_run_mode *run_mode)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

run_mode |

输出 |

表示运行模式。 typedef enum svp_acl_rt_run_mode {

//软件栈运行在SoC的CPU上

SVP_ACL_DEVICE,

//SoC不支持

SVP_ACL_HOST,

} svp_acl_rt_run_mode;

|

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_get_device_count¶

函数功能:获取可用Device的数量,同步接口。

函数原型:

svp_acl_error svp_acl_rt_get_device_count(uint32_t *count)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

count |

输出 |

Device数量。 |

返回值说明:返回0表示成功,返回其它值表示失败。

Context管理¶

svp_acl_rt_create_context¶

函数功能:显式创建一个Context,该Context中包含1个默认Stream,同步接口。

支持以下使用场景:

若不调用svp_acl_rt_create_context接口显式创建Context,那系统会使用默认Context,该默认Context是在调用svp_acl_rt_set_device接口时隐式创建的。

隐式创建Context:适合简单、无复杂交互逻辑的应用,但缺点在于,在多线程编程中,执行结果取决于线程调度的顺序。

显式创建Context:推荐显式,适合大型、复杂交互逻辑的应用,且便于提高程序的可读性、可维护性。

若在某一进程内创建多个Context(Context的数量与Stream相关,Stream数量有限制,请参见svp_acl_rt_create_stream),当前线程在同一时刻内只能使用其中一个Context,建议通过svp_acl_rt_set_current_context接口明确指定当前线程的Context,增加程序的可维护性。

函数原型:

svp_acl_error svp_acl_rt_create_context(svp_acl_rt_context *context, int32_t device_id)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

device_id |

输入 |

指定需要创建context的Device的ID。 |

context |

输出 |

创建的context的指针。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_destroy_context¶

函数功能:销毁一个Context,释放Context的资源,同步接口。只能销毁通过svp_acl_rt_create_context接口创建的Context。

函数原型:

svp_acl_error svp_acl_rt_destroy_context(svp_acl_rt_context context)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

context |

输入 |

指定需要销毁的context。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_set_current_context¶

函数功能:设置线程的Context,同步接口。

支持以下场景:

如果在某线程(例如:thread1)中调用svp_acl_rt_create_context接口显式创建一个Context(例如:ctx1),则可以不调用svp_acl_rt_set_current_context接口指定该线程的Context,系统默认将ctx1作为thread1的Context。

如果没有调用svp_acl_rt_create_context接口显式创建Context,则系统将默认Context作为线程的Context,此时,不能通过svp_acl_rt_destroy_context接口来释放默认Context。

如果多次调用svp_acl_rt_set_current_context接口设置线程的Context,以最后一次为准。

约束说明:

若给线程设置的Context所对应的Device已经被复位,则不能将该Context设置为线程的Context,否则会导致业务异常。

推荐在某一线程中创建的Context,在该线程中使用。若在线程A中调用svp_acl_rt_create_context接口创建Context,在线程B中使用该Context,则需由用户自行保证两个线程中同一个Context下同一个Stream中任务执行的顺序。

函数原型:

svp_acl_error svp_acl_rt_set_current_context(svp_acl_rt_context context)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

context |

输入 |

线程当前的context。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_get_current_context¶

函数功能:

获取线程的Context,同步接口。

如果用户多次调用svp_acl_rt_set_current_context接口设置当前线程的Context,则获取的是最后一次设置的Context。

函数原型:

svp_acl_error svp_acl_rt_get_current_context(svp_acl_rt_context *context)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

context |

输出 |

线程当前的context。 |

返回值说明:返回0表示成功,返回其它值表示失败。

Stream管理¶

svp_acl_rt_create_stream¶

函数功能:创建一个Stream,同步接口。

约束说明:

SoC-cs形态,硬件资源最多支持128个Stream,如果已存在多个默认Stream,只能显式创建N个Stream(N=128-默认Stream个数),例如,若已存在一个默认Stream,则只能显式创建127个Stream。

每个Context对应一个默认Stream,该默认Stream是调用svp_acl_rt_set_device接口或svp_acl_rt_create_context接口隐式创建的。推荐调用svp_acl_rt_create_stream接口显式创建Stream。

隐式创建Stream:适合简单、无复杂交互逻辑的应用,但缺点在于,在多线程编程中,执行结果取决于线程调度的顺序。

显式创建Stream:推荐显式,适合大型、复杂交互逻辑的应用,且便于提高程序的可读性、可维护性。

函数原型:

svp_acl_error svp_acl_rt_create_stream(svp_acl_rt_stream *stream)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

stream |

输出 |

新创建的stream的指针。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_destroy_stream¶

函数功能:销毁指定Stream,只能销毁通过svp_acl_rt_create_stream接口创建的Stream,同步接口。

约束说明:

在调用svp_acl_rt_destroy_stream接口销毁指定Stream前,需要先调用svp_acl_rt_synchronize_stream接口确保Stream中的任务都已完成。

调用svp_acl_rt_destroy_stream接口销毁指定Stream时,需确保该Stream在当前Context下。

在调用svp_acl_rt_destroy_stream接口销毁指定Stream时,需确保其它接口没有正在使用该Stream。

函数原型:

svp_acl_error svp_acl_rt_destroy_stream(svp_acl_rt_stream stream)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

stream |

输入 |

待销毁的stream。 |

返回值说明:返回0表示成功,返回其它值表示失败。

同步等待¶

svp_acl_rt_synchronize_device¶

函数功能:

阻塞应用程序运行,直到正在运算中的Device完成运算,同步接口。

多Device场景下,调用该接口等待的是当前Context对应的Device。

约束说明:一个进程内多线程场景下,不支持多线程并发调用本接口。

函数原型:

svp_acl_error svp_acl_rt_synchronize_device(void)

参数说明:无

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_synchronize_stream¶

函数功能:阻塞应用程序运行,直到指定Stream中的所有任务都完成,同步接口。

函数原型:

svp_acl_error svp_acl_rt_synchronize_stream(svp_acl_rt_stream stream)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

stream |

输入 |

指定需要完成所有任务的stream,如果为NULL则调用默认stream。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_subscribe_report¶

函数功能:注册处理Stream上回调函数的线程。同步接口。

约束说明:

支持多次调用本接口给多个Stream(仅支持同一Device内的多个Stream)注册同一个处理回调函数的线程;

为确保Stream内的任务按调用顺序执行,不支持调用本接口给同一个Stream注册多个处理回调函数的线程;

单进程内调用本接口注册的线程数量如果超过128个,则接口返回失败;

考虑操作系统的线程切换性能开销,建议调用本接口注册的线程数量控制在32个以下(包括32);

同一个进程内,在不同的Device上注册回调函数的线程时,不能指定同一个线程ID。

函数原型:

svp_acl_error svp_acl_rt_subscribe_report(uint64_t thread_id, svp_acl_rt_stream stream)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

thread_id |

输入 |

指定线程的ID。 |

stream |

输入 |

指定Stream。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_launch_callback¶

函数功能:在Stream的任务队列中增加一个需要在板端环境上执行的回调函数。异步接口。

函数原型:

svp_acl_error svp_acl_rt_launch_callback(svp_acl_rt_callback fn, void *user_data, svp_acl_rt_callback_block_type blockType, svp_acl_rt_stream stream)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

fn |

输入 |

指定要增加的回调函数。 回调函数的函数原型为: typedef void (*svp_acl_rt_callback)(void *user_data) |

user_data |

输入 |

待传递给回调函数的用户数据,若fn不需要入参,user_data可以为空。 |

block_type |

输入 |

指定回调函数调用是否阻塞Device运行。 typedef enum svp_acl_rt_callback_block_type {

SVP_ACL_CALLBACK_NO_BLOCK, //非阻塞

SVP_ACL_CALLBACK_BLOCK, //阻塞

} svp_acl_rt_callback_block_type;

|

stream |

输入 |

指定Stream,如果为NULL则调用默认stream。 |

约束说明:用户需要保证传入的fn和user_data的正确性,以及user_data所指向内存空间大小是否足够,否则处理回调函数时会导致程序异常。

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_process_report¶

函数功能:

在timeout时间内,触发回调处理,由svp_acl_rt_subscribe_report接口指定的线程处理回调。同步接口。

用户需新建一个线程,在线程函数内调用本接口。

函数原型:

svp_acl_error svp_acl_rt_process_report(int32_t timeout)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

timeout |

输入 |

超时时间,单位为ms。 取值范围:

|

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_unsubscribe_report¶

函数功能:取消线程注册,Stream上的回调函数不再由指定线程处理。同步接口。

函数原型:

svp_acl_error svp_acl_rt_unsubscribe_report(uint64_t thread_id, svp_acl_rt_stream stream)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

thread_id |

输入 |

指定线程的ID。 |

stream |

输入 |

指定Stream,如果为NULL则调用默认stream。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_set_op_wait_timeout¶

函数功能:

设置等待超时时间。同步接口。

对于需要等待Stream、Device上任务完成的场景,可以调用本接口设置等待超时时间。设置超时时间后,如果等待任务完成的时间超过所设置的时间,则SVP ACL会返回报错。不调用本接口设置等待超时时间,则默认超时时间是120秒。

函数原型:

svp_acl_error svp_acl_rt_set_op_wait_timeout(uint32_t timeout)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

timeout |

输入 |

设置超时时间,单位为秒。 将该参数设置为0时,表示不超时。 取值范围: [0, 4000000]。 |

返回值说明:返回0表示成功,返回其它值表示失败。

内存管理¶

svp_acl_rt_malloc¶

函数功能:

申请Device上的内存,同步接口。

在Device上申请size大小的线性内存,通过*dev_ptr返回已分配内存的虚拟地址指针。

通过该接口申请的Device内存不支持cache缓存,如果用户需要申请支持cache缓存的内存,请参见svp_acl_rt_malloc_cached。

约束说明:

使用svp_acl_rt_malloc接口申请的内存,需要通过svp_acl_rt_free接口释放内存。

频繁调用svp_acl_rt_malloc接口申请内存、调用svp_acl_rt_free接口释放内存,会损耗性能,建议用户提前做内存预先分配或二次管理,避免频繁申请/释放内存。

函数原型:

svp_acl_error svp_acl_rt_malloc(void **dev_ptr, size_t size, svp_acl_rt_mem_malloc_policy policy)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

size |

输入 |

申请内存的大小,单位Byte。 size不能为0。 |

policy |

输入 |

内存分配规则。 typedef enum svp_acl_rt_mem_malloc_policy {

SVP_ACL_MEM_MALLOC_HUGE_FIRST, // SOC不支持申请大页内存,使用该内存分配规则,申请的是普通页的内存

SVP_ACL_MEM_MALLOC_HUGE_ONLY, // SOC不支持, 使用该内存分配规则,申请的是普通页的内存

SVP_ACL_MEM_MALLOC_NORMAL_ONLY, // 仅申请普通页

} svp_acl_rt_mem_malloc_policy;

|

dev_ptr |

输出 |

指向Device上已分配内存的指针的指针。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_malloc_cached¶

函数功能:

申请Device上的内存,同步接口,该接口在任何场景下申请的内存都是支持cache缓存。

在Device上申请size大小的线性内存,通过*dev_ptr返回已分配内存的虚拟地址指针。

通过本接口分配的内存支持cache缓存,对于频繁使用的内存,建议使用本接口分配内存,这样可以提高cpu的读写效率,提升系统性能。当cpu访问此接口申请的内存时,会将内存中的数据放在cache中,而硬件设备(如图像分析引擎)只能访问物理内存,不能访问cache中内容,对于这种cpu和硬件会共同操作的内存,需要调用svp_acl_rt_mem_flush接口做好数据同步。

约束说明:其它约束与svp_acl_rt_malloc接口相同,但使用本接口申请的支持cache缓存的内存,需要用户显式处理cpu与图像分析引擎之间cache的一致性。

函数原型:

svp_acl_error svp_acl_rt_malloc_cached(void **dev_ptr, size_t size, svp_acl_rt_mem_malloc_policy policy)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

dev_ptr |

输出 |

指向Device上已分配内存的指针的指针。 |

size |

输入 |

申请内存的大小,单位Byte。 size不能为0。 |

policy |

输入 |

内存分配规则。 typedef enum svp_acl_rt_mem_malloc_policy {

SVP_ACL_MEM_MALLOC_HUGE_FIRST, // SOC不支持申请大页内存,使用该内存分配规则,申请的是普通页的内存

SVP_ACL_MEM_MALLOC_HUGE_ONLY, // SOC不支持, 使用该内存分配规则,申请的是普通页的内存

SVP_ACL_MEM_MALLOC_NORMAL_ONLY, // 仅申请普通页

} svp_acl_rt_mem_malloc_policy;

|

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_mem_flush¶

函数功能:

将cache中的数据刷新到ddr中,并将cache中的内容设置成无效。

当cache里的数据为最新数据时,为了保证不能直接访问cache的硬件(如图像分析引擎)在访问内存时能够得到正确的数据,此时需要先调用本接口将cache里的内容更新到内存,这样,当硬件访问内存时,保证了数据的一致性和正确性。

此接口应与svp_acl_rt_malloc_cached接口配套使用。

函数原型:

svp_acl_error svp_acl_rt_mem_flush(const void *dev_ptr, size_t size)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

dev_ptr |

输入 |

要flush的ddr内存起始地址。 |

size |

输入 |

要flush的ddr内存大小,单位Byte。 size不能为0。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_mem_invalidate¶

函数功能:

将cache中的数据设置成无效。

针对硬件输出的内存,如果此时cache中有预读引起的脏数据,硬件计算完成后,为了保证CPU后处理能获取到正确的数据,此时需要将cache中预读数据置无效。如果CPU对该内存执行过写操作,调用该接口会将cache中的数据同步到ddr。

此接口应与svp_acl_rt_malloc_cached接口配套使用。

函数原型:

svp_acl_error svp_acl_rt_mem_invalidate(const void *dev_ptr, size_t size)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

dev_ptr |

输入 |

需要指定ddr内存对应的cache无效。 |

size |

输入 |

ddr内存大小,单位Byte。 size不能为0。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_free¶

函数功能:

释放Device上的内存,同步接口。

本接口只能释放通过svp_acl_rt_malloc接口或svp_acl_rt_malloc_cached接口申请的内存。如果应用在Device侧使用svp_acl_rt_malloc_host接口申请内存,也可以通过本接口释放。

函数原型:

svp_acl_error svp_acl_rt_free(const void *dev_ptr)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

dev_ptr |

输入 |

待释放内存的指针。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_malloc_host¶

函数功能:申请Host或Device上的内存,Device上的内存按普通页申请。同步接口。

约束说明:

使用svp_acl_rt_malloc_host接口申请的内存,需要通过svp_acl_rt_free_host接口释放内存。

应用在Host上运行时,调用该接口申请的是Host内存,由系统保证内存首地址64字节对齐。应用在Device上运行时,调用该接口申请的是Device内存,由系统保证内存首地址64字节对齐。

频繁调用svp_acl_rt_malloc_host接口申请内存、调用svp_acl_rt_free_host接口释放内存,会损耗性能,建议用户提前做内存预先分配或二次管理,避免频繁申请/释放内存。

函数原型:

svp_acl_error svp_acl_rt_malloc_host(void **host_ptr, size_t size)

参数说明:

参数名 |

输入/输出 |

说明 |

|---|---|---|

size |

输入 |

申请内存的大小,单位Byte。 size不能为0。 |

host_ptr |

输出 |

“已分配内存的指针”的指针。 |

返回值说明:返回0表示成功,返回其它值表示失败。

svp_acl_rt_free_host¶

函数功能:

释放Host或Device上的内存,同步接口。

应用在Host侧,svp_acl_rt_free_host接口只能释放通过svp_acl_rt_malloc_host接口申请的内存。应用在Device侧,svp_acl_rt_free_host接口既可以释放svp_acl_rt_malloc_host接口申请的内存,也可以释放svp_acl_rt_malloc接口申请的内存。

函数原型: